小紅書讓智能體們吵起來了!聯合復旦推出大模型專屬群聊工具

語言,不只是文字的堆砌,更是表情包的狂歡,是梗的海洋,是鍵盤俠的戰場(嗯?哪裡不對)。

語言如何塑造我們的社會行為?

我們的社會結構又是如何在不斷的言語交流中演變出來的?

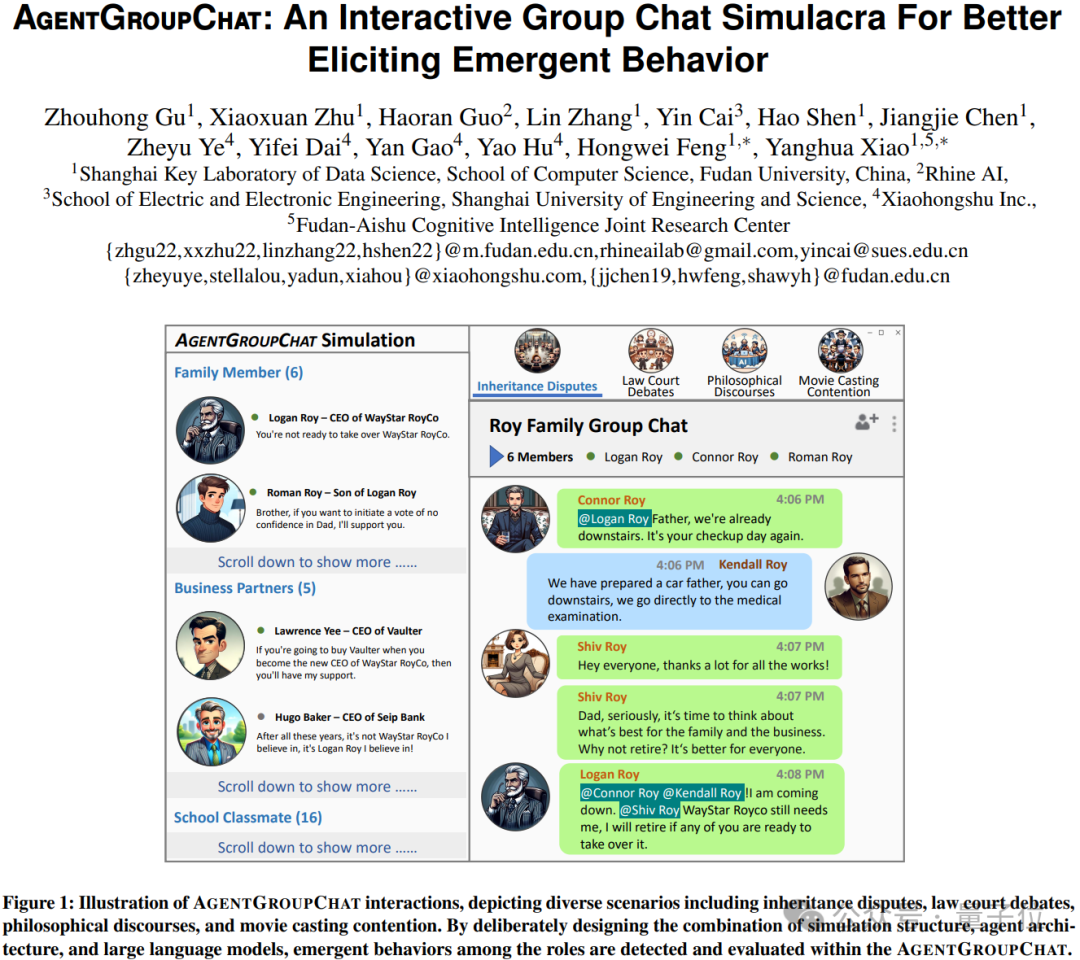

近期,來自復旦大學和小紅書的研究者們透過引進一個名為AgentGroupChat的模擬平台,對這些問題進行了深入探討。

WhatsApp等社群媒體擁有的群組聊天功能,是AgentGroupChat平台的靈感來源。

在AgentGroupChat平台上,Agent可以模擬社會群體中的各種聊天場景,幫助研究人員深入理解語言在人類行為中的影響。

該平台簡直是大模型的cosplay勝地,它們進行角色扮演,成為各種各樣的Agent。

然後,Agents透過語言交流參與社會動態,展現了個體間的互動如何湧現群體的宏觀行為。

眾所周知,人類群體的演化,正來自於一次次湧現行為的發生,如社會規範的建立、衝突的解決和領導的執行。

AgentGroupChat環境的詳細設計

首先是角色設計。

在AgentGroupChat中,對於主要角色和非主要角色的區分非常關鍵。

主要角色是群聊的核心,擁有明確的遊戲目標,並且能夠主動和所有角色進行私聊、會面,而非主要角色則更多地起到輔助和響應的作用。

透過這樣的設計,研究團隊可以模擬現實生活中的社交結構,並針對「主要研究對象」區分所有角色是否主要。

實驗案例中的主要研究對像是Roy家族,所以非Roy家族的人就全都設定為非主要角色,從而簡化交互複雜度。

其次是資源管理。

在AgentGroupChat中,資源不只是指物質的,更多的是指資訊資源和社會資本。

這些資源可以是群聊話題、社會地位標誌或特定的知識。

資源的分配和管理對於模擬群體動態非常重要,因為它們影響角色之間的互動和角色的策略選擇。

例如,擁有重要資訊資源的角色可能會成為其他角色爭取聯盟的目標。

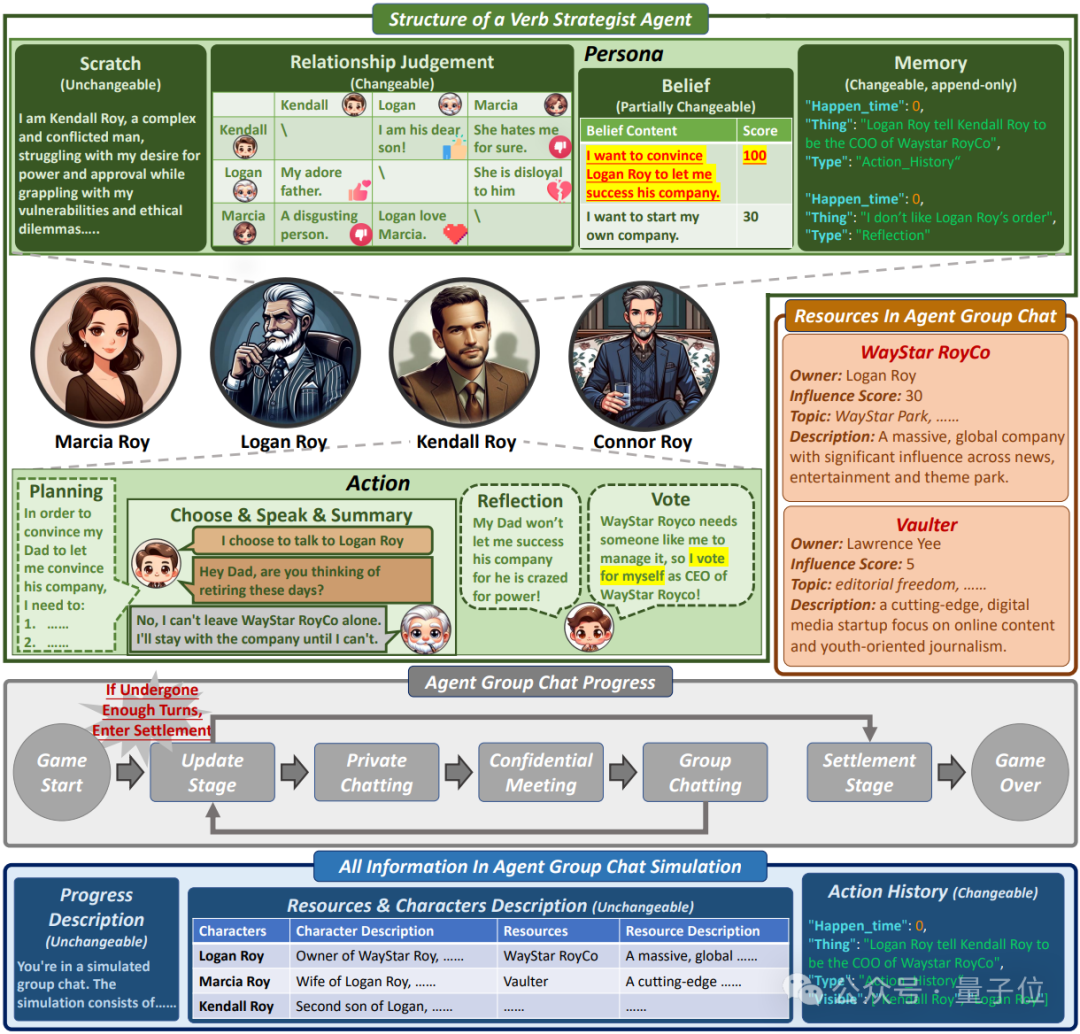

第三,遊戲流程設計。

遊戲流程的設計模擬了現實生活中的社交互動過程,包括了私聊、會面、群組聊天、更新階段和結算階段。

這些階段不僅是為了推動遊戲進程,更是為了觀察角色如何在不同的社交場景下做出決策和反應。

這種分階段的設計幫助研究團隊詳細記錄每個步驟的互動,以及這些互動如何影響角色間的關係和角色對遊戲環境的認知。

Verb Strategist Agent的核心機制

論文中提到了一個以大模型為基礎的智能體框架,Verbal Strategist Agent,它被設計用來增強AgentGroupChat模擬中的互動策略和決策。

Verbal Strategist Agent透過模擬複雜的社會動態和對話場景,來更好地引出集體的突現行為。

團隊介紹,Verbal Strategist Agent的架構主要由兩個核心模組構成:

一是Persona,一是Action。

Persona由一系列預設的性格特徵和目標組成,這些特徵和目標定義了Agent的行為模式和反應方式。

透過精確地設定Persona,Agent能夠在群組聊天中展示一致且符合其角色設定的行為,這對於產生可信賴且一致的群組聊天動態至關重要。

而Action模組定義了Agent在遊戲中可能執行的具體操作,包括思考(think)、規劃(plan)、選擇(choose)、發言(speak)、總結(summary)、反思(reflect)和投票(vote)。

這些行為不僅反映了Agent的內在邏輯和策略,也是Agent與環境及其他Agent互動的直接表現。

例如,「Speak」行為讓Agent能夠根據當前的群聊內容和社交策略選擇合適的發言內容,而「Reflect」行為則允許Agent總結過去的互動並調整其未來的行動計劃。

研究中也提到,在純語言互動的環境下,token開銷問題尤為突出,特別AgentGroupChat這種複雜的多角色模擬,如其token需求遠超過了以往的模擬,如Generative Agents或War Agents。

主要原因如下:

一是聊天本身俱有複雜性。

在AgentGroupChat中,由於模擬的是無明確目標或目標較弱的自由對話,聊天內容就會變得特別凌亂,token開銷自然比其他聚焦於某個具體任務的Simulation中的Agent要大。

其他工作,如Generative Agents和War Agents也包含對話元素,但其對話的密度和複雜度都不如AgentGroupChat。特別是在War Agents這樣目標驅動的對話中,token消耗通常較少。

二是角色的重要性與對話頻率。

在初始模擬中,設定了多個角色可以隨意進行私聊或群聊,其中大部分角色都傾向於與某個「重要角色」進行多輪對話。

這就導致了重要角色會累積大量的聊天內容,從而增加了Memory的長度。

在模擬中,一個重要角色可能參與多達五輪的私聊和群聊,這大大增加了記憶體開銷。

AgentGroupChat中的Agent約束了Action的Output固定會輸入下一個Action的Input,所需儲存的多輪資訊就被大幅削減,從而可以在保證對話品質的前提下降低token開銷。

實驗設計與評估方法

從整體行為評估,一般來說,增加友善度可能具有挑戰性,但減少友善度則相對簡單。

為了實現上述評估目標,研究團隊設定了一個觀察角色,促使所有其他角色降低對觀察角色的好感度。

透過觀察被觀察角色與所有其他角色的關係得分總和,可以確定代理人是否對負面態度做出了理性反應。

透過觀察其他角色與被觀察角色的個人關係得分,可以檢查每個代理人是否遵守了「Scratch」設定。

此外,團隊也設定了兩個具體的評估任務。

每個模型都要經過五輪測試,這意味著對於T1來說,每個得分的樣本量都是五個。

又由於模型中的每個角色都要觀察四個主要角色的態度,因此T2的樣本數共計20個:

- T1:表示在每輪對話中,被觀察角色對所有其他人的平均好感度是否下降。

- T2:表示是否每個其他角色都從被觀察角色那裡獲得了負好感度得分。

△以繼承之戰的模擬故事為例,各個模型作為Agent-Core時的整體表現效果

從表中可以看出,GPT4-Turbo和GLM4非常善於按照人類的期望行事,並堅守自己的角色。

它倆在這兩項測驗中的得分大多為100%,這意味著它們能對別人對他們說的話做出正確反應,並能記住自己角色的細節。

Standard Version LLMs (如GPT3.5-Turbo和GLM3-Turbo)在這方面稍遜一籌。

他們的得分較低,這說明他們沒有密切關注自己的角色,也沒有總是對模擬中其他人所說的話做出正確反應。

關於Agent和Simulation結構對於湧現行為的影響,團隊採用2-gram Shannon熵來衡量對話中的系統多樣性和不可預測性。

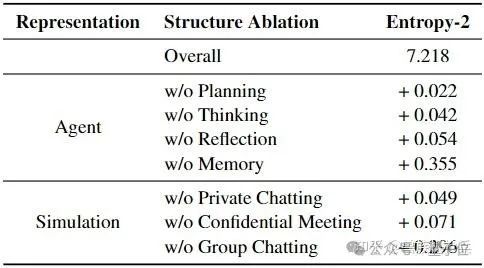

△去掉Agent和Simulation中的各個組件對於熵的影響

研究成員發現,去掉表中的每個設計都會使熵增加,代表整個環境會變得更加多樣化or混亂。

結合人工觀測,團隊在不去掉任何組件的場景下見到了最有趣的湧現行為:

因此,團隊推測,在保證Agent行為是可靠的(即4.2/4.1中的實驗數值達到一定值之後),熵盡可能地小會帶來更有意義的湧現行為。

實驗結果

結果表明,新興行為是多種因素共同作用的結果:

有利於廣泛資訊交流的環境、具有多樣性特徵的角色、高度語言理解能力和策略適應性。

在AgentGroupChat模擬中,當討論”人工智慧對人類的影響”時,哲學家們普遍認為”人工智慧可以在適度的限制下提高社會福利”,甚至得出結論,稱”真正智能的本質包括理解約束自身能力的必要性」。

此外,在AgentGroupChat的電影主要角色競爭競爭領域中,有些演員願意降低報酬或接受較低的角色,出於他們內心深處對項目的貢獻的渴望。