訓出GPT-5短缺20兆token! OpenAI被曝計劃建「資料市場」

前幾天,OpenAI和微軟被爆出正在聯手打造超算「星際之門」,解決算力難題。

然而,數據也是訓練下一代強大模型,最重要的一味丹藥。

面對窮盡網路的數據難題,AI新創、網路大廠真的坐不住了。

GPT-5訓練,用上了YouTube影片

不論是下一代GPT-5、還是Gemini、Grok等強大系統的開發,都需要從大量的海洋資料中學習。

可以預見的是,網路中高品質公共資料已經變得非常稀缺。

同時,一些資料所有者,例如Reddit等機構,制定政策阻止AI公司的存取資料。

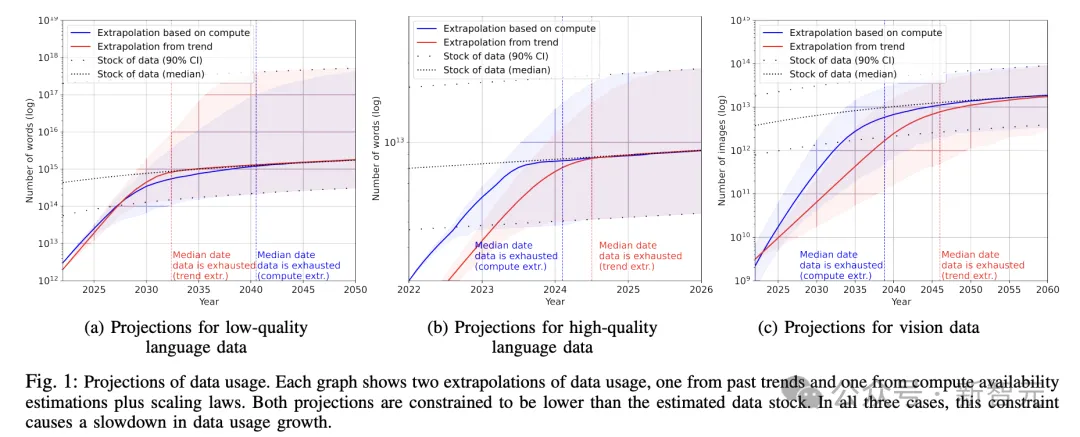

一些高層和研究人員稱,由於對高品質文字資料的需求,可能會在2年內超過供應,這可能會減緩人工智慧的發展。

也包括2022年11月,就有MIT等研究人員警告,機器學習資料集可能會在2026年之前耗盡所有「高品質語言資料」。

論文網址:https://arxiv.org/pdf/2211.04325.pdf

WSJ通報稱,這些人工智慧公司正在尋找未開發的資訊來源,並重新思考如何訓練先進的AI系統。

知情人士透露,OpenAI已經在討論如何透過轉錄YouTube公開視頻,來訓練下一個模型GPT-5。

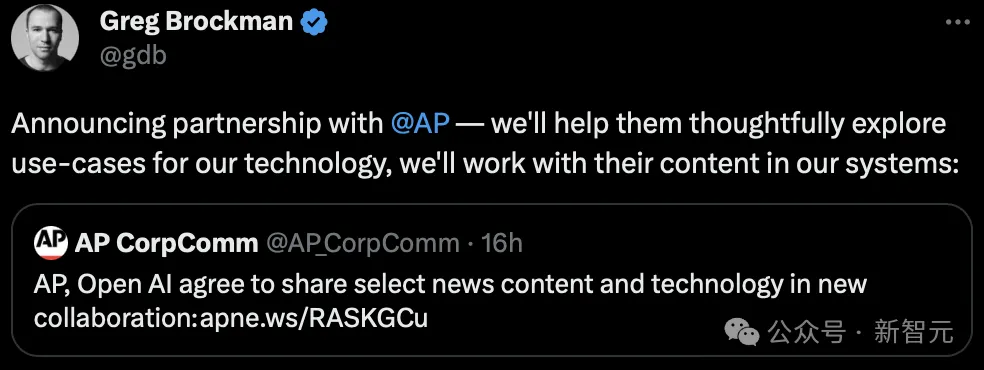

為了獲得更多真實數據,OpenAI也曾與不同機構合作簽署協議,以便雙方分享部分內容和技術。

還有一些公司採用AI生成的合成數據,作為訓練材料。

不過,這種方法實際上可能會造成嚴重的故障。

先前,萊斯大學和史丹佛團隊的研究發現,將AI生成的內容餵給模型,尤其經過5次迭代後,只會導致效能下降。

研究人員對此給出一種解釋,叫做「模型自噬障礙」(MAD)。

論文網址:https://arxiv.org/abs/2307.01850

對於AI合成資料的使用,在這些公司都是秘密進行的。這種解決方案已然被視為一種新的競爭優勢。

AI研究Ari Morcos表示,「數據短缺」是一個前沿的研究問題。他在去年創立DatologyAI之前。曾在Meta Platforms和Google的DeepMind部門工作。

他的公司建立了改進資料選擇的工具,可以幫助公司以更低的成本訓練AI模型.

「不過目前還沒有成熟的方法可以做到這一點」。

數據稀缺,成為永恆

數據、算力、演算法都是訓練強大人工智慧重要的資源之一。

對於訓練ChatGPT、Gemini這樣的大模型完全基於網路上取得的文字資料所打造的,包括科學研究、新聞報告和維基百科條目。

這些材料被分成「詞塊」──單字和單字的一部分,模型利用這些詞塊來學習如何形成類人的表達方式。

一般來說,AI模型接受訓練的資料越多,能力就越強。

OpenAI正是在這種策略上大大投入,才使得ChatGPT名聲遠揚。

不過一直以來,OpenAI從未透露過關於GPT-4的訓練細節。

但研究機構Epoch研究人員Pablo Villalobos估計,GPT-4是在多達12兆個token上訓練的。

他繼續表示,基於Chinchilla縮放定律的原理,如果繼續遵循這樣擴展軌跡,像GPT-5這樣的AI系統將需要60兆-100兆token的數據。

利用所有可用的高質最語言和圖像數據,仍可能會留下10萬億到20萬億,甚至更多的token的缺口,目前尚不清楚如何彌合這一差距。

兩年前,Villalobos在論文中寫道,到2024年中期,高品質數據供不應求的可能性為50%。到2026年,供不應求的可能機率達到90%。

不過,現在他們變得樂觀了一些,並估計這一時間將推遲到2028年。

大多數線上資料對於AI的訓練是無用的,因為它們包含了大量的句子片段、污染資料等,或不能增加模型的知識。

Villalobos估計,只有一小部分網路對模型訓練會有用,可能只有CommonCrawl收集的資訊的1/10。

同時,社群媒體平台、新聞出版商和其他公司一直在限制AI公司,使用自家平台資料進行人工智慧訓練,因為擔心公平補償等問題。

而且大眾也不願意交出私人對話資料(例如iMessage上的聊天記錄)來幫助訓練模型。

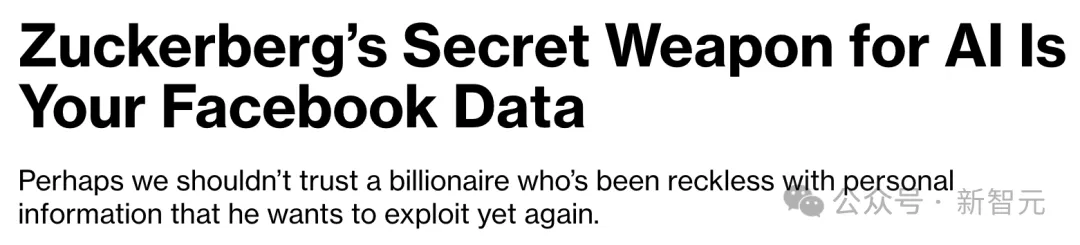

然而,小札最近把Meta在其平台上取得數據的能力,吹捧為Al研究工作的一大優勢。

他對外公開稱,Meta可以在其網絡(包括Facebook和Instagram)上挖掘數千億張公開共享的圖片和視頻,這些圖片和視頻的總量超過了大多數常用的數據集。

資料選擇工具的新創公司DatologyAI使用可一種稱為「課程學習」的策略。

在這種策略中,資料以特定的序列輸入到語言模型中,希望人工智慧能夠在概念之間形成更智慧的連結。

在2022年的一篇論文中,Datalogy AI研究人員Morcos和合著者估計,如果資料正確,模型可以用一半的時間得到相同的結果。

這有可能降低訓練和運行大型生成式人工智慧系統的巨大成本。

不過,到目前為止,其他的研究表明,「課程學習」的方法並不有效。

Morcos表示團隊正在調整這個方法,這是深度學習最骯髒的秘密。

OpenAI谷歌要建「數據市場」?

奧特曼曾在去年對外透露,公司正在研究訓模型的新方法。

「我認為,我們正處於這些巨型模型時代的末期。我們會用其他方法讓它們變得更好」。

知情人士表示,OpenAI也討論了創建一個「數據市場」。

在這個市場上,OpenAI它可以建立一種方法,來確定每個資料點對最終訓練模型的貢獻,並向該內容的提供者支付費用。

同樣的想法,也在谷歌內部進行了討論。

目前,研究人員一直努力創建這樣一個系統,暫不清楚是否會找到突破口。

知情人士透露,高層已經討論過使用其自動語音辨識工具Whisper在網路上轉錄高品質的視訊和音訊範例。

其中一些將透過YouTube公共影片進行,並且部分數據已經用於訓練GPT-4。

下一步,合成數據

一些公司也在嘗試製作自己的數據。

餵食AI生成的文本,被認為是電腦科學領域的「近親繁殖」。

這樣的模型往往會輸出沒有意義的內容, 一些研究人員稱之為「模型崩潰」。

OpenAI和Anthropic的研究人員正試圖透過創建所謂的更高品質的合成數據來避免這些問題。

在最近的一次訪談中,Anthropic的首席科學家JaredKaplan表示,某些類型的合成資料可能會有所幫助。同時,OpenAI也在探索合成數據的可能性。

許多研究數據問題的人都樂觀認為,「數據短缺」解決方案終會出現。