用Vision Pro即時訓練機器狗! MIT博士生開源專案火了

Vision Pro又現火爆新玩法,這回還和具身智能連結了~

就像這樣,MIT小哥利用Vision Pro的手部追蹤功能,成功實現了對機器狗的即時控制。

不只開門這樣的動作能精準get:

也幾乎沒什麼延遲。

Demo一出,不只網友們大讚鵝妹嚶,各路具身智能研究人員也嗨了。

例如這位準清華叉院博士生:

還有人大膽預測:這就是我們與下一代機器互動的方式。

專案如何實現,作者小哥樸英孝(Younghyo Park)已經在GitHub上開源。相關App可以直接在Vision Pro的App Store下載。

用Vision Pro訓練機器狗

具體來看看作者小哥開發的App—— Tracking Steamer。

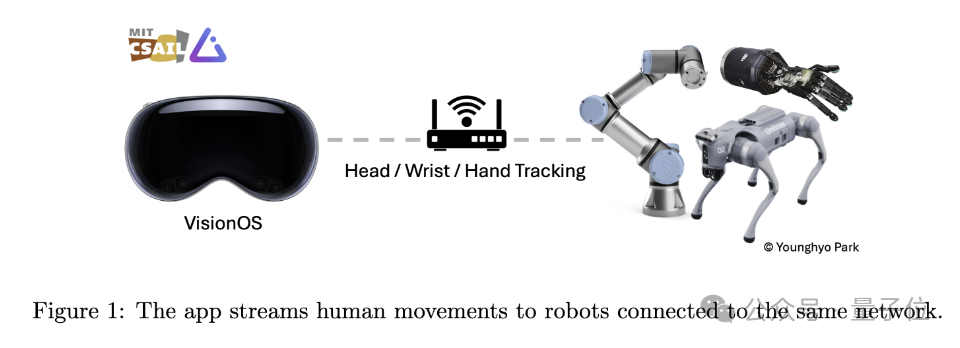

顧名思義,這個應用程式旨在利用Vision Pro追蹤人類動作,並將這些動作數據即時傳輸到同一WiFi下的其他機器人設備上。

動作追蹤的部分,主要依靠蘋果的ARKit庫來實現。

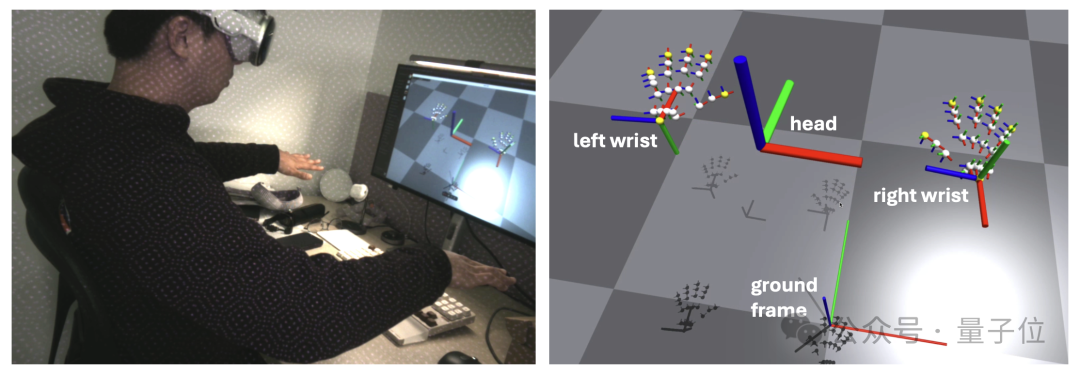

其中頭部追蹤呼叫的是queryDeviceAnchor。使用者可以透過長按數字錶冠來重置頭部框架到目前位置。

手腕和手指追蹤則透過HandTrackingProvider實現。它能夠追蹤左右手腕相對於地面框架的位置和方向,以及每隻手25個手指關節相對於手腕框架的姿態。

網路通訊方面,這個App使用gRPC作為網路通訊協定來串流資料。這使得數據能被更多裝置訂閱,包括Linux、Mac和Windows設備。

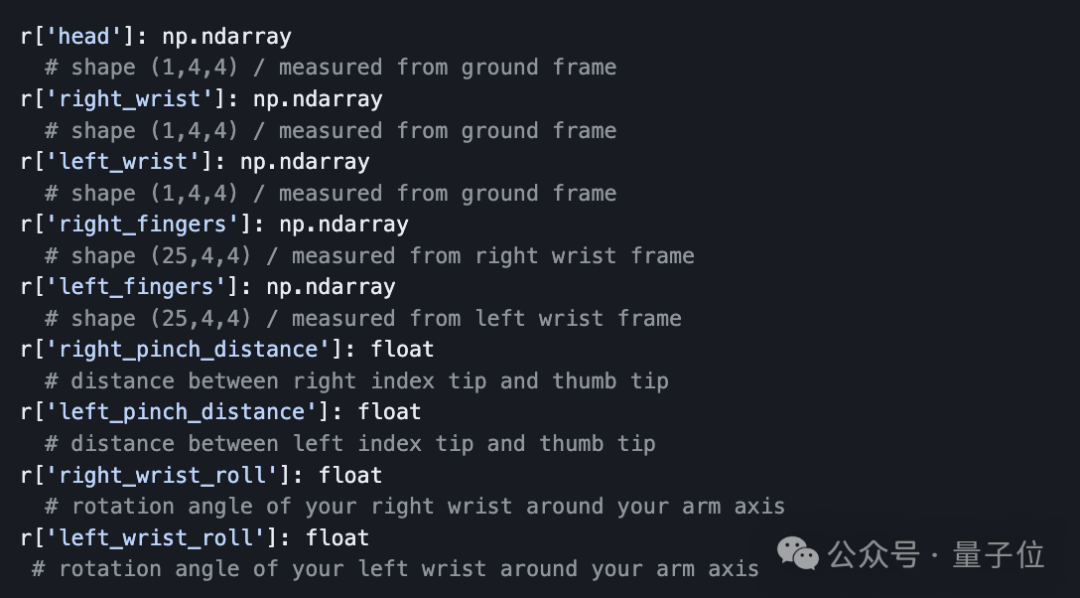

另外,為了方便資料傳輸,作者小哥也準備了一個Python API,讓開發者能夠透過程式設計方式訂閱和接收從Vision Pro串流傳輸的追蹤資料。

API傳回的資料是字典形式,包含頭部、手腕、手指的SE(3)姿態訊息,即三維位置和方向。開發者可以直接在Python中處理這些數據,用於對機器人的進一步分析和控制。

就像不少專業人士所指出的那樣,別看機器狗的動作還是由人類控制,事實上,相比於「操控」本身,結合模仿學習演算法,人類在這個過程中,更像是機器人的教練。

而Vision Pro透過追蹤使用者的動作,提供了一種直覺、簡單的互動方式,使得非專業人員也能夠為機器人提供精準的訓練資料。

作者本人也在論文中寫道:

在不久的將來,人們可能會像日常戴眼鏡一樣戴著Vision Pro這樣的設備,想像一下我們可以從這個過程中收集多少數據!

這是一個充滿前景的資料來源,機器人可以從中學習到,人類是如何與現實世界互動的。

最後,提醒一下,如果你想上手試試這個開源項目,那麼除了必備一台Vision Pro之外,還需要準備:

- 蘋果開發者帳戶

- Vision Pro開發者配件(Developer Strap,售價299美元)

- 安裝了Xcode的Mac電腦

嗯,看樣子還是得先讓蘋果賺一筆了(doge)。

專案連結:https://github.com/Improbable-AI/VisionProTeleop?tab=readme-ov-file