讓ChatGPT告訴你如何搭建支持ChatGPT算力的無損網絡

新華三數據中心網絡將持續聚焦超寬、智能、融合、綠色的演進,提供更智能、更綠色、更強算力的數據中心網絡產品與方案。

隨著全球企業數字化轉型的加速進行,當前以ChatGPT為代表的應用在生產、生活領域的不斷深入,ChatGPT熱度暴增的背後,代表著人工智能等內容自動生成技術所需要的基礎設施需求也水漲船高。

隨著全球企業數字化轉型的加速進行,當前以ChatGPT為代表的應用在生產、生活領域的不斷深入,ChatGPT熱度暴增的背後,代表著人工智能等內容自動生成技術所需要的基礎設施需求也水漲船高。

未來5年我國智能算力規模年復合增長率將達52.3%

據《2022-2023中國人工智能計算力發展評估報告》,2021年中國智能算力規模達155.2 EFLOPS(FP16), 預計到2026年中國智能算力規模將達到1271.4 EFLOPS。2021~2026年期間,預計中國智能算力規模年復合增長率達52.3%。

隨著“東數西算”工程、新型基礎設施等國家政策規劃出台,我國智算中心掀起建設熱潮。當前我國超過30個城市正在建設或提出建設智算中心,整體佈局以東部地區為主,並逐漸向中西部地區拓展。從發展基礎層面看,圍繞AI產業化和產業AI化的發展思路,人工智能產業已初步形成以異構芯片、算力設施、算法模型、產業應用為核心的架構體系,智算中心具備建設基礎。

據《2022-2023中國人工智能計算力發展評估報告》,2021年中國智能算力規模達155.2 EFLOPS(FP16), 預計到2026年中國智能算力規模將達到1271.4 EFLOPS。2021~2026年期間,預計中國智能算力規模年復合增長率達52.3%。

隨著“東數西算”工程、新型基礎設施等國家政策規劃出台,我國智算中心掀起建設熱潮。當前我國超過30個城市正在建設或提出建設智算中心,整體佈局以東部地區為主,並逐漸向中西部地區拓展。從發展基礎層面看,圍繞AI產業化和產業AI化的發展思路,人工智能產業已初步形成以異構芯片、算力設施、算法模型、產業應用為核心的架構體系,智算中心具備建設基礎。

構建規模化智能算力底座

當前ChatGPT其訓練模型主要是在通用基礎大模型底座GPT-3上。訓練超大基礎模型需要多方面的關鍵技術作為支撐,算法、算力和數據缺一不可。算法依賴大模型參數的提升以及模型本身的優化,而算力和數據則需要依賴傳統的GPU服務器、存儲以及網絡來實現相互促進。

數據顯示,ChatGPT的總算力消耗約為3640PF-days(即假如每秒計算一千萬億次,需要計算3640天),需要7~8個投資規模30億、算力500P的數據中心才能支撐運行。ChatGPT按照1300萬/天的訪問量,估算需要3萬+ GPU。GPU在訓練過程中會進行頻繁通信,包括P2P通信和Collective通信。在節點內,GPU之間的通信互聯帶寬可達400GB/s。在節點之間,GPU通信使用RDMA網絡,通過GDR(GDR, GPU Direct RDMA)技術支持, RDMA網卡可以繞過CPU、內存,直接從遠端節點讀取數據到GPU顯存。

算力中心網絡層面需要通過智能無損存儲網絡等技術實現網絡和應用系統融合優化,通過流量控制技術和擁塞控制技術來提升網絡整體的吞吐量,降低網絡時延。

對於新華三智能無損網絡而言,具備超大規模組網是構建智能算力的必經之路。目前以ChatGPT為代表的AIGC,包括它背後的大模型的意義,不僅僅是在落地本身,它的科研價值可能更大。普遍認為率先落地的幾個行業可能包括科研類、教育、互聯網相關產業等。

以大規模化部署的互聯網行業為例,某互聯網公司緊跟chatGPT等AI訓練為契機搭建單PoD支持4000個200G端口的集群算力網絡。在以科研、教育為依託的智算中心當前PoD內部署端口數通常在1000~4000個之間,因此新華三提供了多種可選的高性能網絡方案,完全滿足用戶不同業務場景規模。

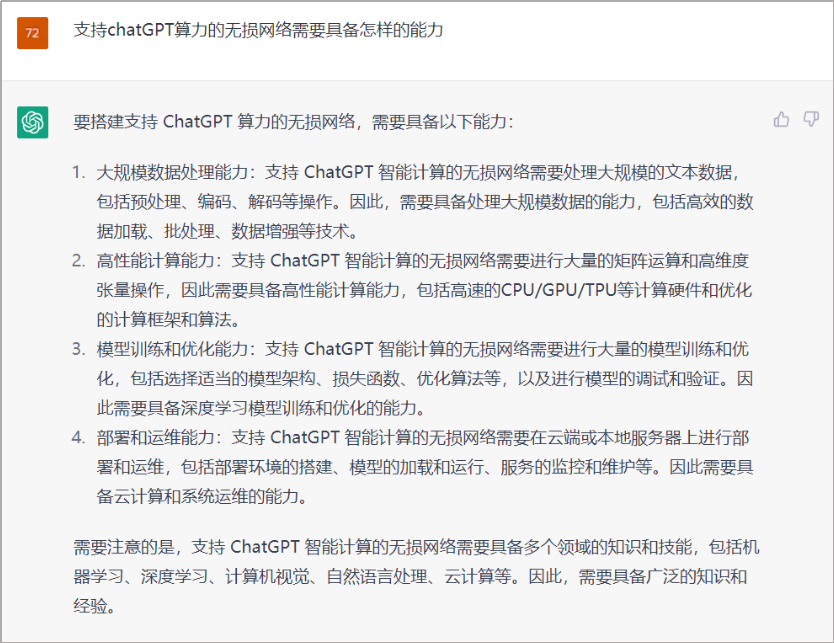

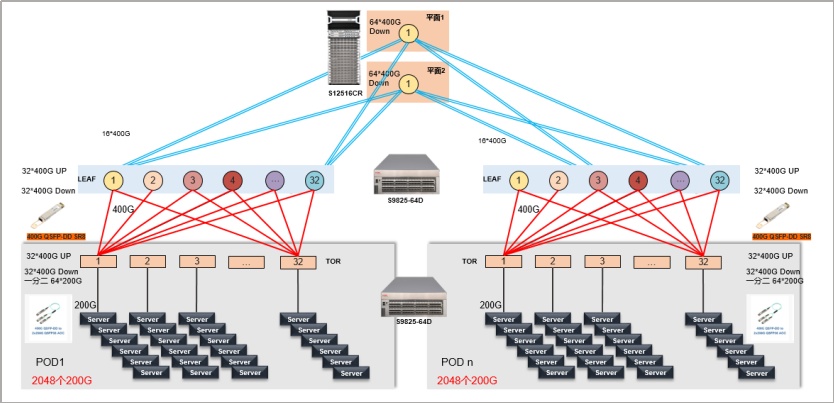

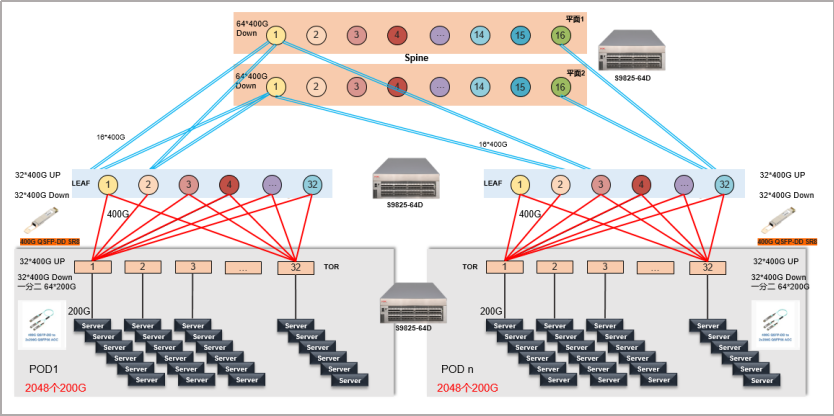

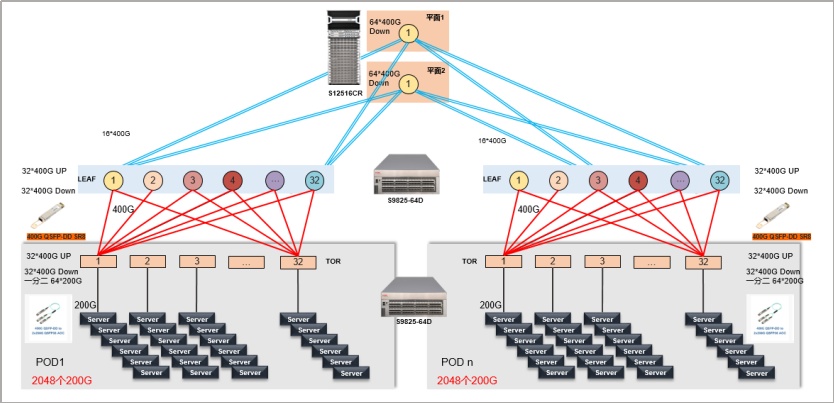

盒盒組網:當前主力的GPU服務器100G/200G/400G網卡速率,以新華三采用最新的S9825/S9855等系列三層ToR/Leaf/Spine組網架構為例,Spine採用雙平面並且保證ToR上下行收斂比滿足1:1要求。在服務器接入速率400G下單PoD可以支持1024台服務器,集群可以提供2048台400G服務器規模接入;若採用200G速率則可以提供單PoD支持2048台服務器,集群最大支持32個PoD理論可滿足6.5萬台服務器規模接入;若採用100G速率接入則可以滿足集群最大可超過十萬台服務器規模接入。

圖1:三級盒式架構200G接入組網

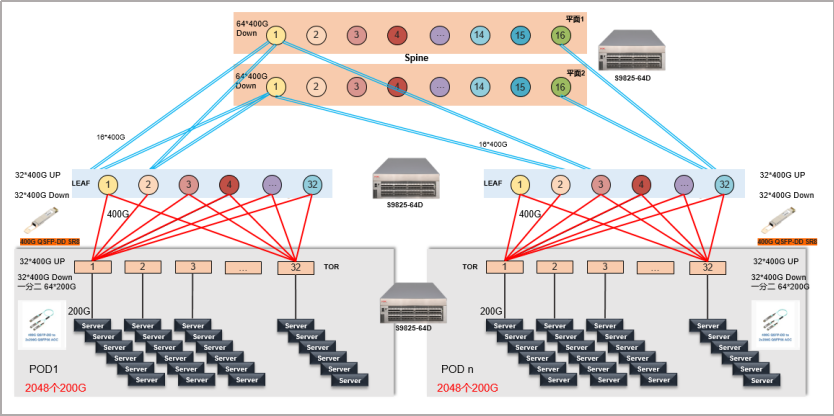

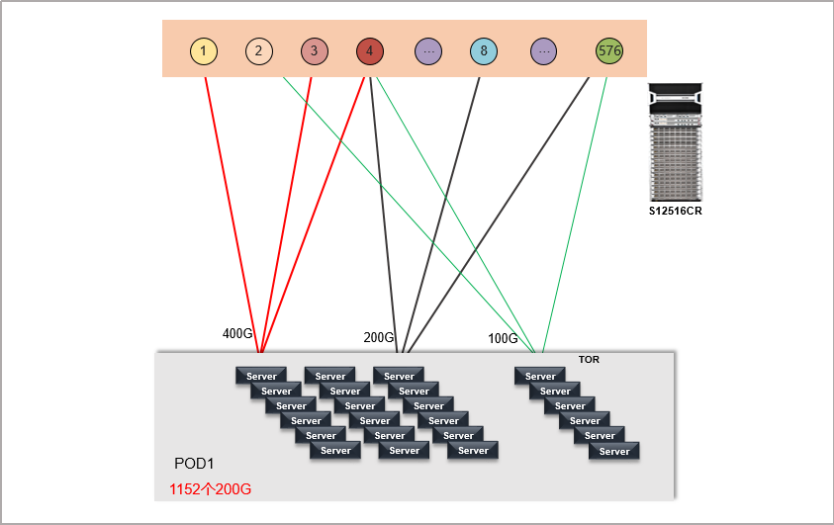

而對於確定性規模的無損網絡而言,新華三提供“一框即無損”的輕量級智能無損網絡部署方案,同樣可以滿足絕大多數場景的智算組網需求。

以S12516CR滿配576個400G端口為例,單框作為作為ToR直接於服務器網卡連接實現1:1收斂,最大可以支持單PoD 576個400G QSFP DD端口接入;200G QSFP56可以滿足最大1152個端口接入;而100G QSFP56可以滿足最大1536個端口接入。需要注意的是採用400G DR4直接拆分可以得到超過2000個DR1封裝的100G端口,而當前主流網卡均不支持DR1。採用單框無損的優勢顯而易見,採用組網架構摒棄傳統的Leaf/Spine架構,可以有效降低設備數量,降低數據轉發跳數有效降低數據轉發時延,同時無需計算多層級下的收斂比以及設備規模等,大大簡化部署和選型難度並且有效提升組網效率。對於確定性規模的智能無損網絡不失為一種新的嘗試。

圖2:“一框即無損” 200G接入組網

框盒組網:而對於有著更大規模組網的需求,新華三數據中心網絡提供框盒無損架構。

同樣以GPU服務器100G/200G/400G網卡速率為例,若採用新華三旗艦數據中心框式產品S12500CR系列構建ToR/Leaf/Spine三層組網架構,單台S12516CR作為Spine並且保證ToR上下行收斂比滿足1:1要求。在服務器接入速率400G下單PoD可以支持千台服務器,集群理論最大可以提供近59台400G服務器規模接入;若採用200G速率則可以提供單PoD支持兩千台服務器,集群提供近118萬台服務器規模接入;若採用100G速率接入集群最大可以提供超200萬台服務器規模接入。下圖即為三層框式架構200G接入組網

當前ChatGPT其訓練模型主要是在通用基礎大模型底座GPT-3上。訓練超大基礎模型需要多方面的關鍵技術作為支撐,算法、算力和數據缺一不可。算法依賴大模型參數的提升以及模型本身的優化,而算力和數據則需要依賴傳統的GPU服務器、存儲以及網絡來實現相互促進。

數據顯示,ChatGPT的總算力消耗約為3640PF-days(即假如每秒計算一千萬億次,需要計算3640天),需要7~8個投資規模30億、算力500P的數據中心才能支撐運行。ChatGPT按照1300萬/天的訪問量,估算需要3萬+ GPU。GPU在訓練過程中會進行頻繁通信,包括P2P通信和Collective通信。在節點內,GPU之間的通信互聯帶寬可達400GB/s。在節點之間,GPU通信使用RDMA網絡,通過GDR(GDR, GPU Direct RDMA)技術支持, RDMA網卡可以繞過CPU、內存,直接從遠端節點讀取數據到GPU顯存。

算力中心網絡層面需要通過智能無損存儲網絡等技術實現網絡和應用系統融合優化,通過流量控制技術和擁塞控制技術來提升網絡整體的吞吐量,降低網絡時延。

對於新華三智能無損網絡而言,具備超大規模組網是構建智能算力的必經之路。目前以ChatGPT為代表的AIGC,包括它背後的大模型的意義,不僅僅是在落地本身,它的科研價值可能更大。普遍認為率先落地的幾個行業可能包括科研類、教育、互聯網相關產業等。

以大規模化部署的互聯網行業為例,某互聯網公司緊跟chatGPT等AI訓練為契機搭建單PoD支持4000個200G端口的集群算力網絡。在以科研、教育為依託的智算中心當前PoD內部署端口數通常在1000~4000個之間,因此新華三提供了多種可選的高性能網絡方案,完全滿足用戶不同業務場景規模。

盒盒組網:當前主力的GPU服務器100G/200G/400G網卡速率,以新華三采用最新的S9825/S9855等系列三層ToR/Leaf/Spine組網架構為例,Spine採用雙平面並且保證ToR上下行收斂比滿足1:1要求。在服務器接入速率400G下單PoD可以支持1024台服務器,集群可以提供2048台400G服務器規模接入;若採用200G速率則可以提供單PoD支持2048台服務器,集群最大支持32個PoD理論可滿足6.5萬台服務器規模接入;若採用100G速率接入則可以滿足集群最大可超過十萬台服務器規模接入。

圖1:三級盒式架構200G接入組網

而對於確定性規模的無損網絡而言,新華三提供“一框即無損”的輕量級智能無損網絡部署方案,同樣可以滿足絕大多數場景的智算組網需求。

以S12516CR滿配576個400G端口為例,單框作為作為ToR直接於服務器網卡連接實現1:1收斂,最大可以支持單PoD 576個400G QSFP DD端口接入;200G QSFP56可以滿足最大1152個端口接入;而100G QSFP56可以滿足最大1536個端口接入。需要注意的是採用400G DR4直接拆分可以得到超過2000個DR1封裝的100G端口,而當前主流網卡均不支持DR1。採用單框無損的優勢顯而易見,採用組網架構摒棄傳統的Leaf/Spine架構,可以有效降低設備數量,降低數據轉發跳數有效降低數據轉發時延,同時無需計算多層級下的收斂比以及設備規模等,大大簡化部署和選型難度並且有效提升組網效率。對於確定性規模的智能無損網絡不失為一種新的嘗試。

圖2:“一框即無損” 200G接入組網

框盒組網:而對於有著更大規模組網的需求,新華三數據中心網絡提供框盒無損架構。

同樣以GPU服務器100G/200G/400G網卡速率為例,若採用新華三旗艦數據中心框式產品S12500CR系列構建ToR/Leaf/Spine三層組網架構,單台S12516CR作為Spine並且保證ToR上下行收斂比滿足1:1要求。在服務器接入速率400G下單PoD可以支持千台服務器,集群理論最大可以提供近59台400G服務器規模接入;若採用200G速率則可以提供單PoD支持兩千台服務器,集群提供近118萬台服務器規模接入;若採用100G速率接入集群最大可以提供超200萬台服務器規模接入。下圖即為三層框式架構200G接入組網

兼備規模組網和信元交換

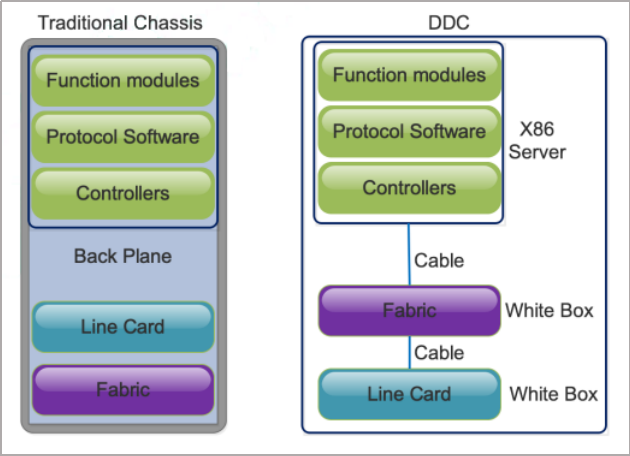

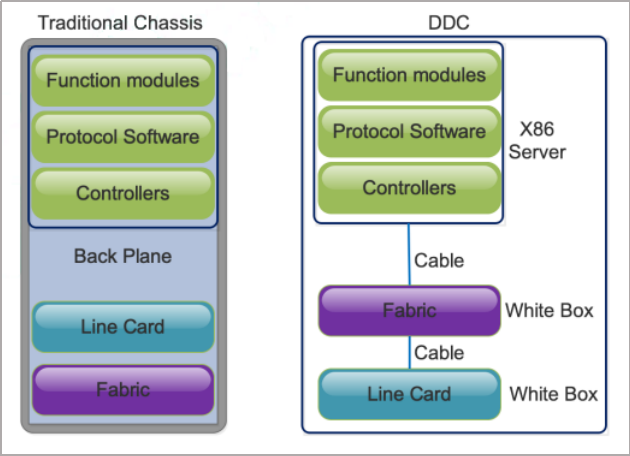

對於數據中心交換機而言,不論是傳統的機框式或者盒式交換機隨著端口速率從100G 提升到400G。不僅要面臨功耗問題,同樣要解決盒式組網的Hash精度以及大像老鼠流。因此新華三數據中心交換機在構建智能無損算力數據中心網絡時優先採用DDC(Distributed Disaggregated Chassis)技術應對日益增長的算力網絡方案。DDC 技術通過對大機框設備進行分佈式解耦,採用盒式交換機作為轉發線卡和交換網板,靈活分佈式部署在多個機櫃, 優化組網規模以及功耗分佈問題,同時DDC盒式交換機之間依舊採用信元交換。

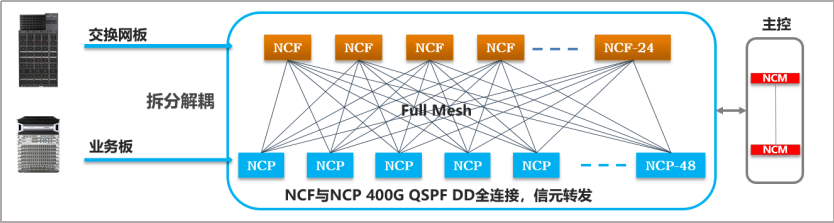

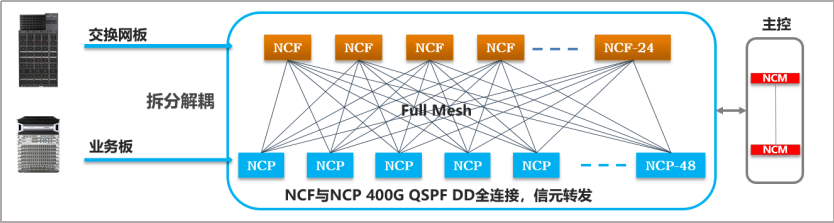

DDC系統各角色名稱:

NCP:Network Cloud Packet (Line card in Chassis)

NCF:Network Cloud Fabric (Fabric card in Chassis)

NCM:Network Cloud Management (Main Management card in Chassis)

圖4:DDC架構

圖5:DDC架構解耦,400G Full mesh全互聯

以S12516CR為例,單台設備可支持2304台100G服務器規模並且支持1:1收斂。DDC方案將控制端元獨立解耦,在NCP以及NCF之間採用400G全互聯同時支持信元轉發,支持數據中心Leaf和Spine無阻塞,有效提升數據報文轉發效率。經測試DDC在Alltoall場景有一定優勢,完成時間提高20-30%。同時相比傳統盒式組網,DDC硬件收斂性能優勢明顯,從端口的up down 測試對比可以發現採用DDC的收斂時間不足盒式組網時間的1%。

對於數據中心交換機而言,不論是傳統的機框式或者盒式交換機隨著端口速率從100G 提升到400G。不僅要面臨功耗問題,同樣要解決盒式組網的Hash精度以及大像老鼠流。因此新華三數據中心交換機在構建智能無損算力數據中心網絡時優先採用DDC(Distributed Disaggregated Chassis)技術應對日益增長的算力網絡方案。DDC 技術通過對大機框設備進行分佈式解耦,採用盒式交換機作為轉發線卡和交換網板,靈活分佈式部署在多個機櫃, 優化組網規模以及功耗分佈問題,同時DDC盒式交換機之間依舊採用信元交換。

DDC系統各角色名稱:

NCP:Network Cloud Packet (Line card in Chassis)

NCF:Network Cloud Fabric (Fabric card in Chassis)

NCM:Network Cloud Management (Main Management card in Chassis)

圖4:DDC架構

圖5:DDC架構解耦,400G Full mesh全互聯

以S12516CR為例,單台設備可支持2304台100G服務器規模並且支持1:1收斂。DDC方案將控制端元獨立解耦,在NCP以及NCF之間採用400G全互聯同時支持信元轉發,支持數據中心Leaf和Spine無阻塞,有效提升數據報文轉發效率。經測試DDC在Alltoall場景有一定優勢,完成時間提高20-30%。同時相比傳統盒式組網,DDC硬件收斂性能優勢明顯,從端口的up down 測試對比可以發現採用DDC的收斂時間不足盒式組網時間的1%。

網絡智能化+流量可視化

智算中心的服務模式從提供算力為主向提供“算法+算力”轉變,在智能無損網絡中同樣需要AI無損算法加持。

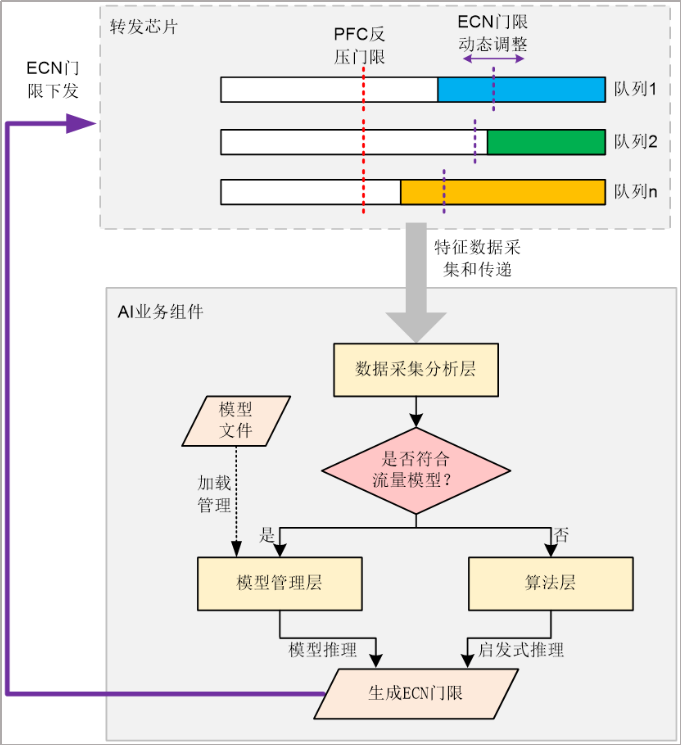

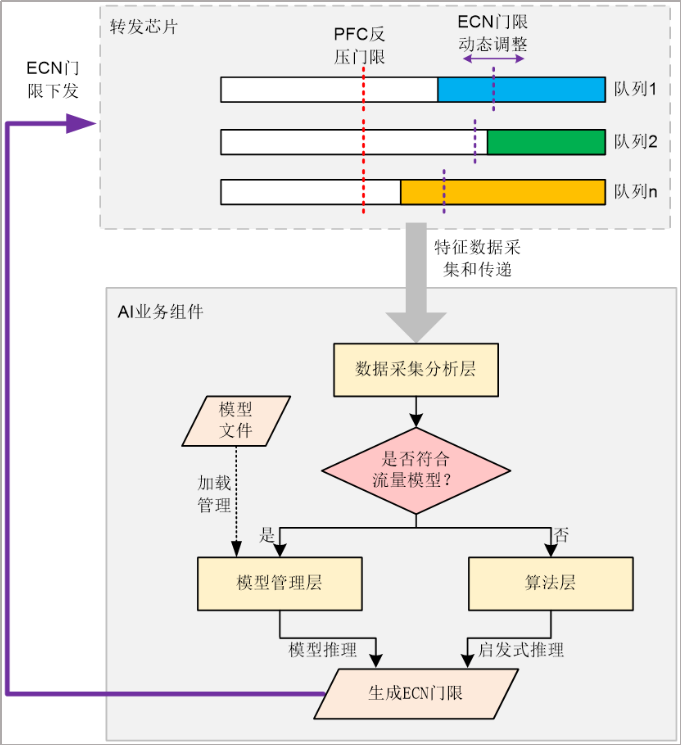

無損網絡中各個隊列轉發的數據流量特徵會隨時間動態變化,網絡管理員通過靜態設置ECN門限時,並不能滿足實時動態變化的網絡流量特徵。新華三無損網絡交換機支持AI ECN功能利用設備本地或分析器上的AI業務組件,按照一定規則動態優化ECN門限。其中,AI業務組件是實現ECN動態調優的關鍵,是內置在網絡設備或者分析器中的系統進程,它主要包括三個層次的功能框架:

- 數據採集分析層:提供用於獲取海量待分析的特徵數據的數據採集接口,並對獲取到的這些數據進行預處理和分析。

- 模型管理層:管理模型文件,並基於用戶加載的AI功能模型,推理得到AI ECN門限。

- 算法層:調用數據採集分析層的接口得到實時特徵數據,按照固定步長的搜索試算法計算得到AI ECN門限。

圖6:AI ECN功能實現示意圖

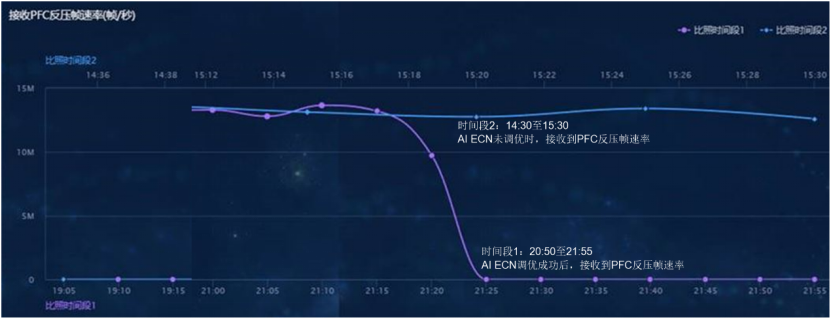

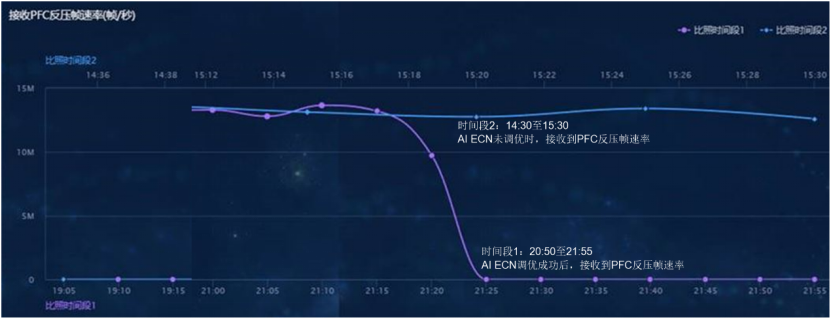

另外,新華三數據中心網絡提供AI ECN運維可視化。根據AI業務組件在網絡中的實施位置不同,AI ECN功能可以分為集中式AI ECN和分佈式AI ECN兩種模式:

- 分佈式AI ECN:AI業務組件集成在設備本地,通過在設備中增加專門的神經網絡(GPU)芯片來滿足AI業務組件對算力的需求。

- 集中式AI ECN:AI業務組件由分析器實現。適用於未來SDN網絡架構,方便包括AI ECN在內的所有AI業務進行集中式管控和可視化運維。

在上述兩種場景中,均可以藉助SeerAnalyzer分析器的優勢,為用戶呈現可視化的AI ECN參數調優效果。

圖7:AI ECN調優前後PFC反壓幀速率對比

回顧過去,新華三已經在智能無損網絡領域與諸多頭部企業達成深度合作。而在未來,新華三數據中心網絡將持續聚焦超寬、智能、融合、綠色的演進,提供更智能、更綠色、更強算力的數據中心網絡產品與方案。

引用文獻:

1、光明網:ChatGPT火爆帶動算力需求,我國算力規模能否支撐?

2、《智能計算中心創新發展指南》

3、《DDC 技術白皮書》

智算中心的服務模式從提供算力為主向提供“算法+算力”轉變,在智能無損網絡中同樣需要AI無損算法加持。

無損網絡中各個隊列轉發的數據流量特徵會隨時間動態變化,網絡管理員通過靜態設置ECN門限時,並不能滿足實時動態變化的網絡流量特徵。新華三無損網絡交換機支持AI ECN功能利用設備本地或分析器上的AI業務組件,按照一定規則動態優化ECN門限。其中,AI業務組件是實現ECN動態調優的關鍵,是內置在網絡設備或者分析器中的系統進程,它主要包括三個層次的功能框架:

- 數據採集分析層:提供用於獲取海量待分析的特徵數據的數據採集接口,並對獲取到的這些數據進行預處理和分析。

- 模型管理層:管理模型文件,並基於用戶加載的AI功能模型,推理得到AI ECN門限。

- 算法層:調用數據採集分析層的接口得到實時特徵數據,按照固定步長的搜索試算法計算得到AI ECN門限。

圖6:AI ECN功能實現示意圖

另外,新華三數據中心網絡提供AI ECN運維可視化。根據AI業務組件在網絡中的實施位置不同,AI ECN功能可以分為集中式AI ECN和分佈式AI ECN兩種模式:

- 分佈式AI ECN:AI業務組件集成在設備本地,通過在設備中增加專門的神經網絡(GPU)芯片來滿足AI業務組件對算力的需求。

- 集中式AI ECN:AI業務組件由分析器實現。適用於未來SDN網絡架構,方便包括AI ECN在內的所有AI業務進行集中式管控和可視化運維。

在上述兩種場景中,均可以藉助SeerAnalyzer分析器的優勢,為用戶呈現可視化的AI ECN參數調優效果。

圖7:AI ECN調優前後PFC反壓幀速率對比

回顧過去,新華三已經在智能無損網絡領域與諸多頭部企業達成深度合作。而在未來,新華三數據中心網絡將持續聚焦超寬、智能、融合、綠色的演進,提供更智能、更綠色、更強算力的數據中心網絡產品與方案。

引用文獻:

1、光明網:ChatGPT火爆帶動算力需求,我國算力規模能否支撐?

2、《智能計算中心創新發展指南》

3、《DDC 技術白皮書》