340B險勝70B,Kimi機器人貼臉「嘲諷」英偉達新開源模型

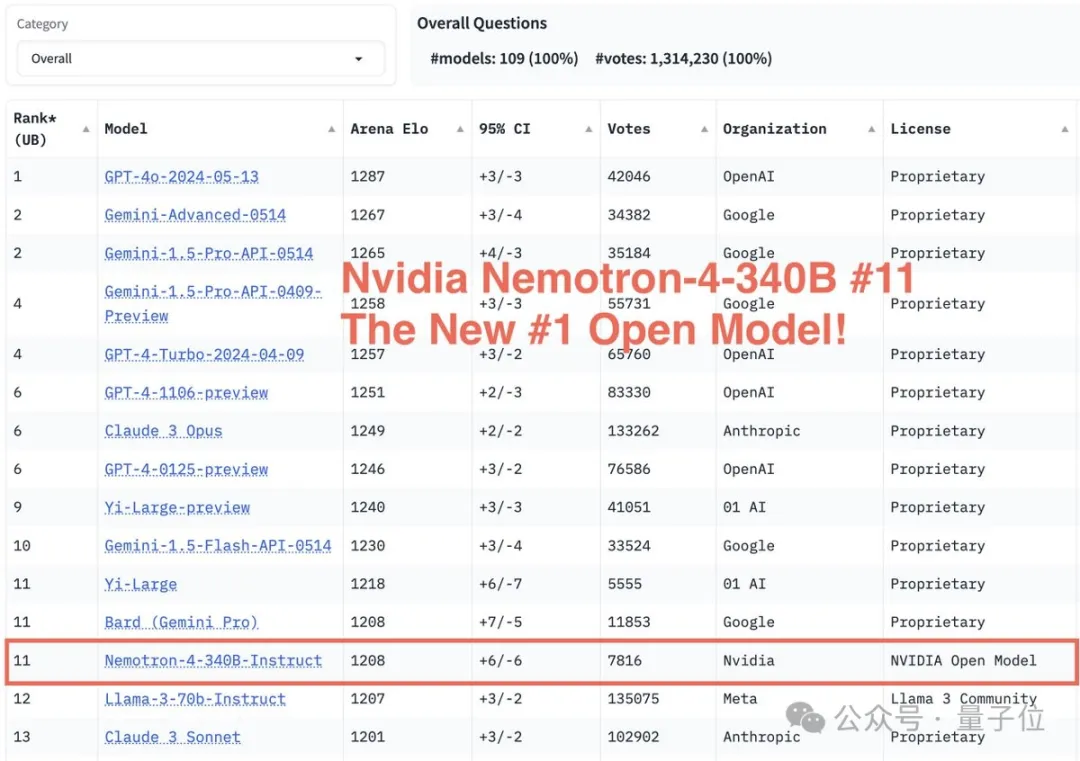

排名超過Llama-3-70B,英偉達Nemotron-4 340B問鼎競技場最強開源模型!

前兩天,英偉達突然開源了其通用大模型Nemotron的3400億參數版本。

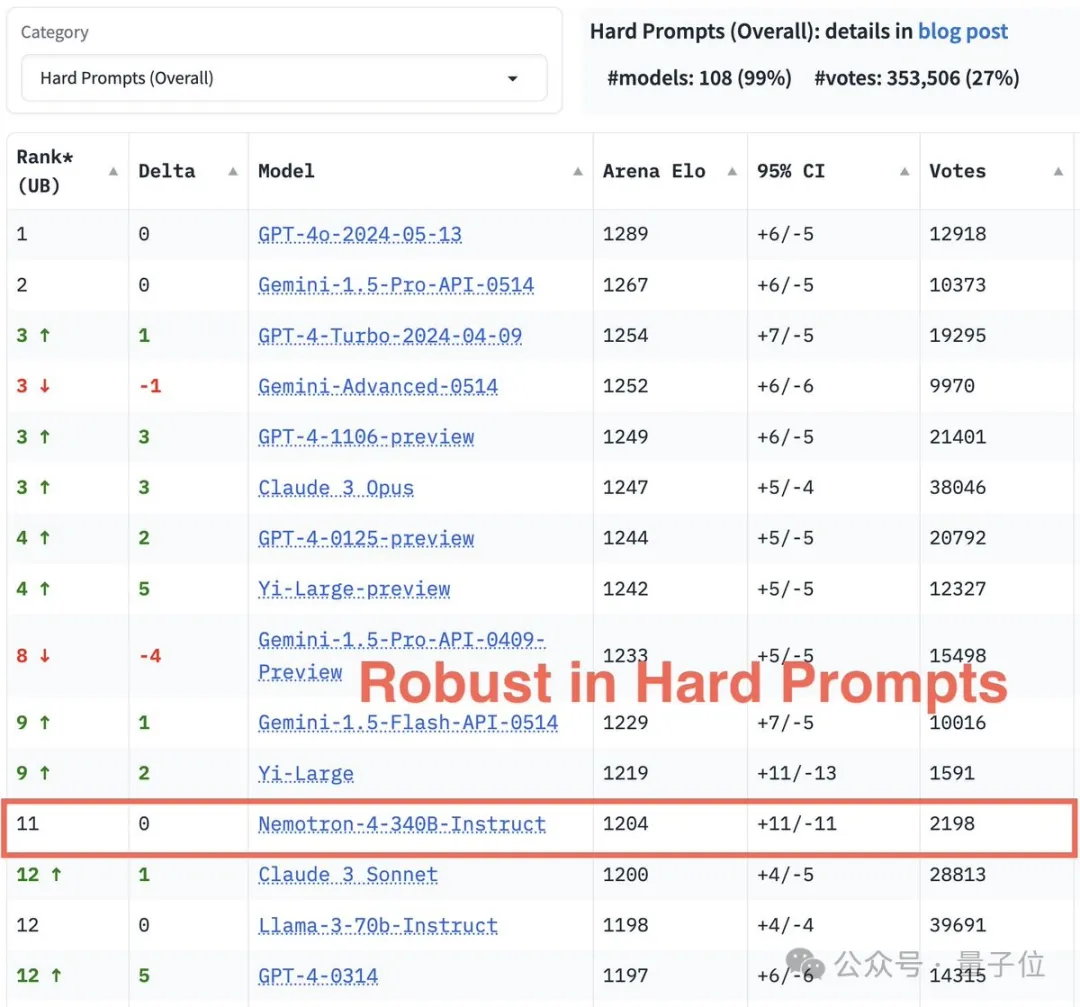

就在最近,競技場更新了排名情況:

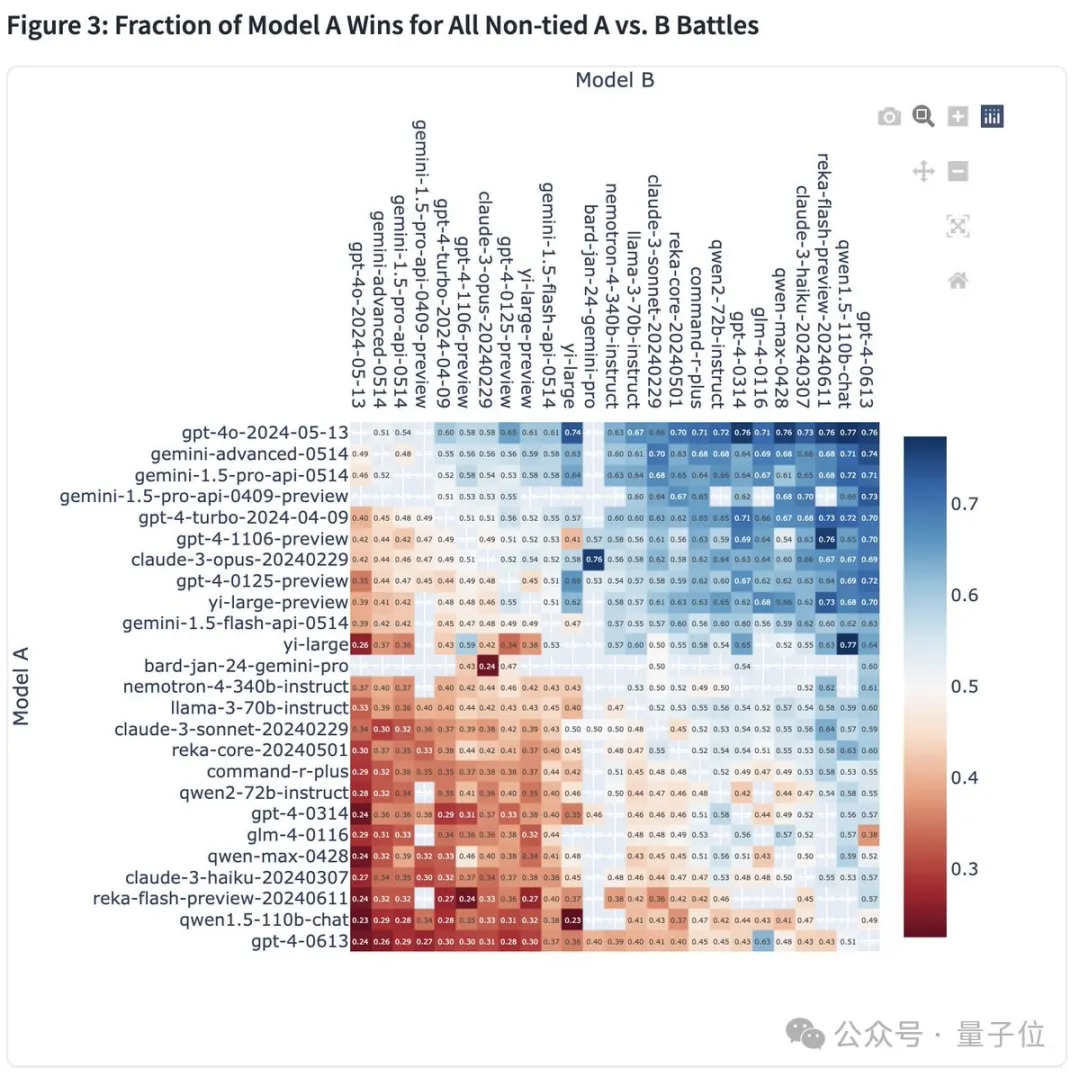

勝率熱圖顯示,Nemotron-4 340B對Llama-3-70B的勝率為53%。

究竟Nemotron-4 340B表現如何?接下來一起看看。

新模型最新戰績

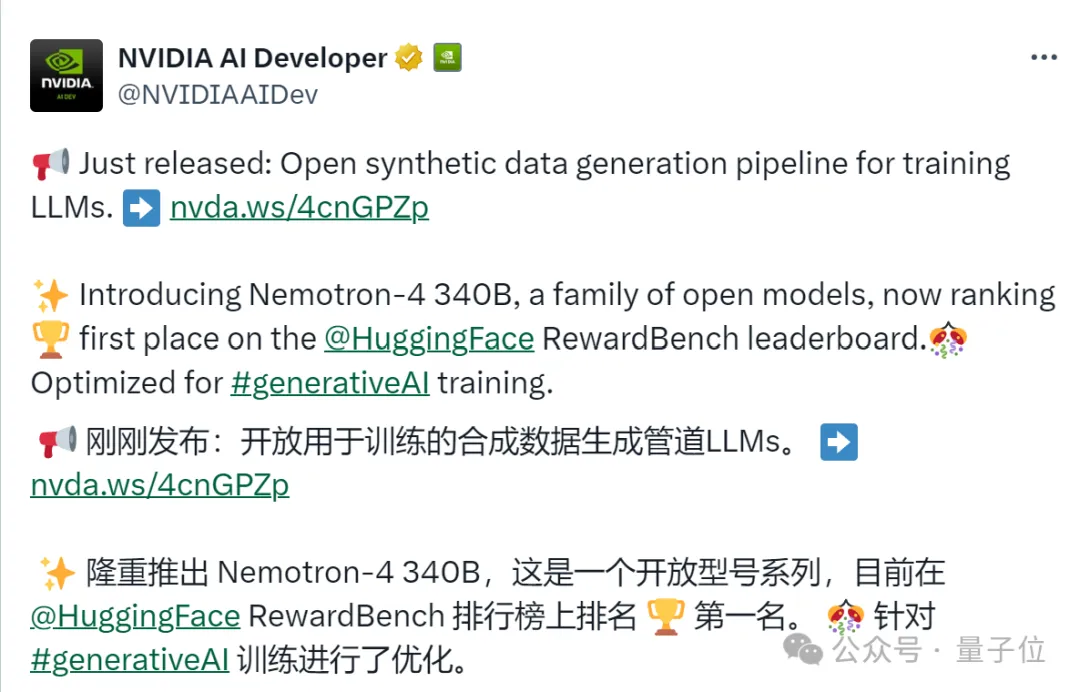

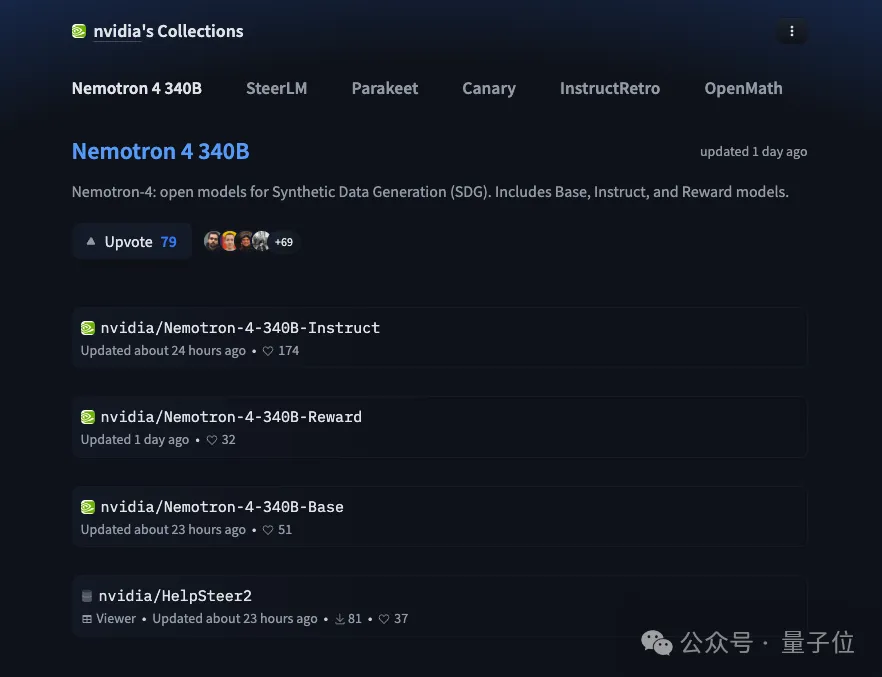

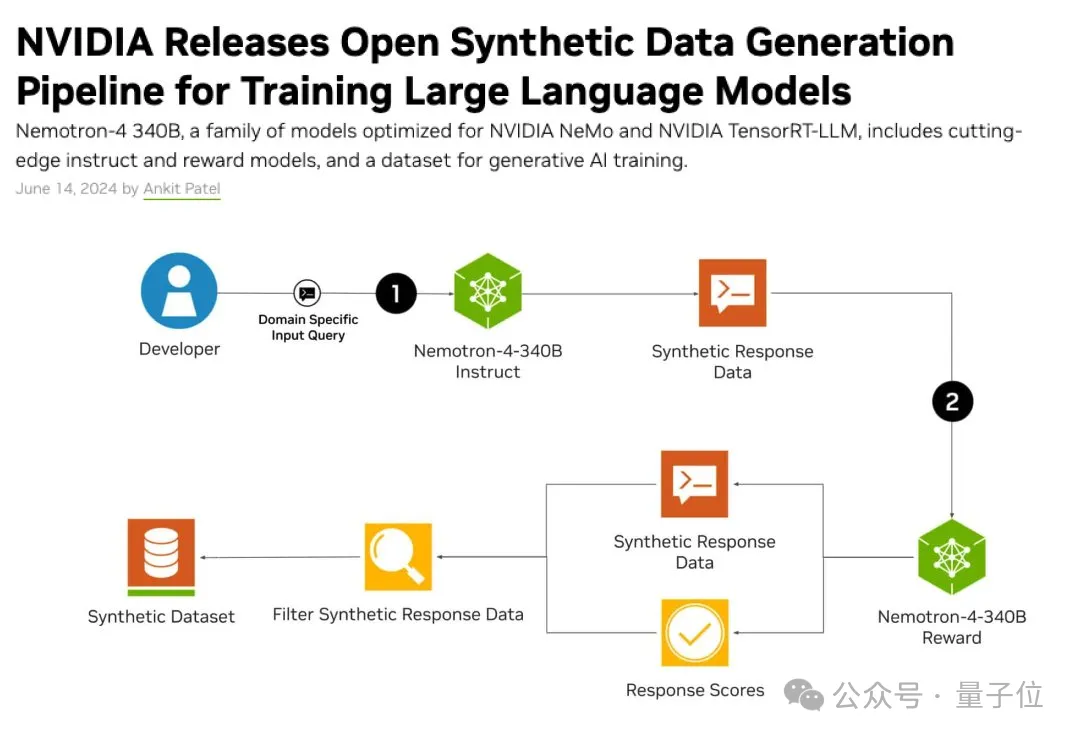

簡單回顧一下,英偉達上週五突然宣布開源Nemotron-4 340B,該系列包括基礎模型、指令模型和獎勵模型,用於產生訓練和改進LLM的合成資料。

Nemotron-4 340B一發佈便瞬時登頂Hugging Face RewardBench榜一!

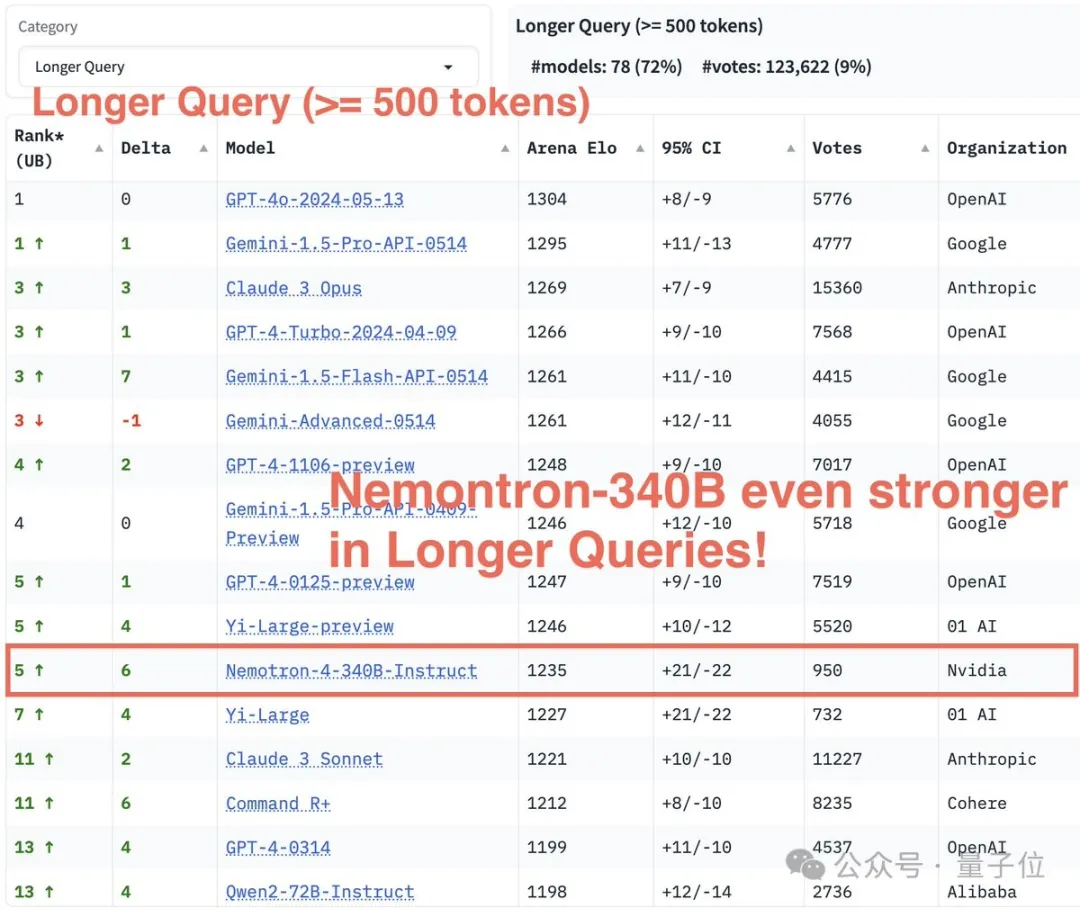

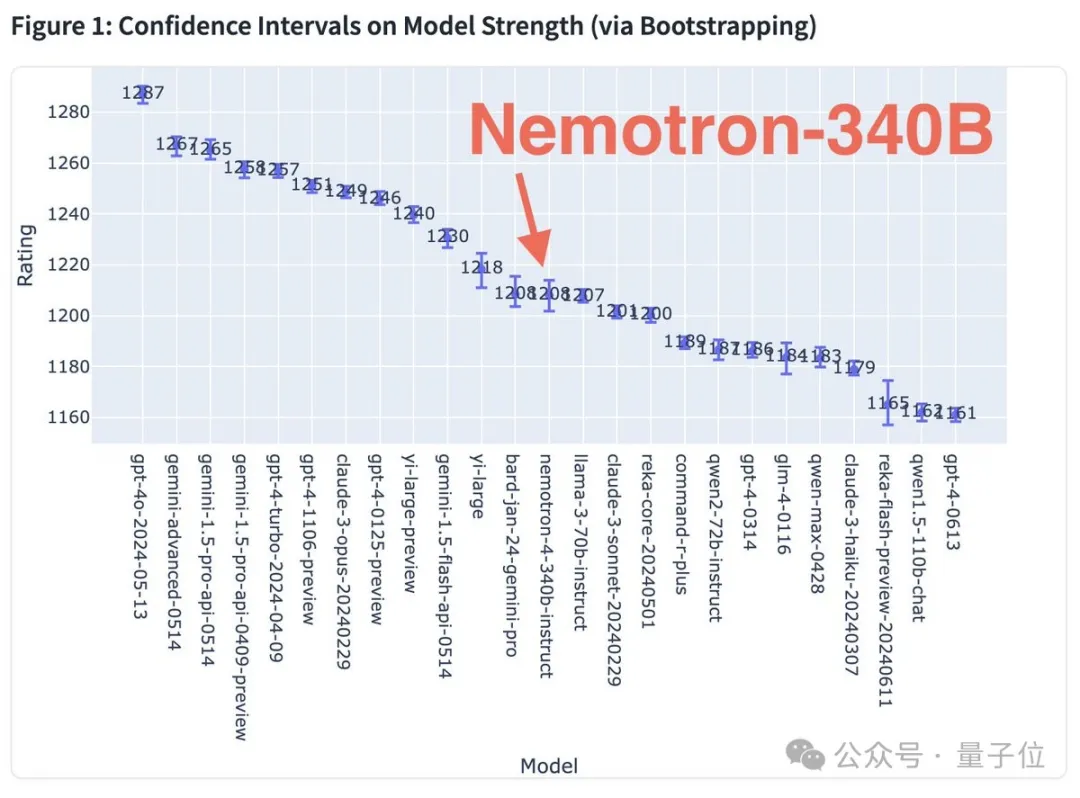

緊接著,競技場新近公佈了Nemotron-4 340B的一系列評測結果。

在長文本查詢(長度>=500個token)中,Nemotron-4 340B排在第5位,超過Claude 3 Sonnet及Qwen 2-72B等主流開源模型。

在處理硬提示方面,Nemotron-4 340B超越了Claude 3 Sonnet和Llama3 70B-Instruct,顯示出其在應對複雜和高難度查詢時的卓越能力。

在整體效能評估中,Nemotron-4 340B的評分和穩定性均處於中上水平,超越了多款知名開源模型。

概括一下,Nemotron-4 340B已經取得了不錯的戰績,直接超越了Mixtral 8x22B、Claude sonnet、Llama3 70B、Qwen 2,有時甚至可以和GPT-4一較高下。

其實,以前這個模型就曾登上大模型競技場LMSys Chatbot Arena,當時它的別名是june-chatbot。

具體來說,這個模型支援4K上下文視窗、50多種自然語言和40多種程式語言,訓練資料截止到2023年6月。

訓練資料方面,英偉達採用了高達9兆個token。其中,8兆用於預訓練,1兆用於繼續訓練以提高品質。

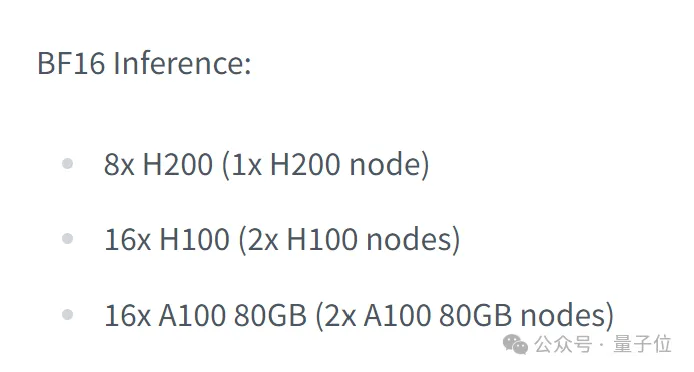

在BF16精準度下,模型的推理需要8塊H200,或16塊H100/A100 80GB。如果是在FP8精度下,則只需8塊H100。

值得一提的是,指令模型的訓練是在98%的合成資料上完成的。

而合成資料無疑是Nemotron-4 340B的最大亮點,它有可能徹底改變訓練LLM的方式。

合成數據才是未來

面對最新排名,興奮的網友突然咂摸出一絲不對勁:

用340B對戰70B,而且還是險勝,這事兒有點說不過去吧!

就連機器人Kimi也對此開啟了「嘲諷」模式:

英偉達這波操作,參數大得像宇宙,性能卻跟Llama-3-70B肩並肩,科技界的」大號小能」啊!

對此,在英偉達負責AI模型對齊和定制的Oleksii Kuchaiev拿出了關鍵法寶:

是的,Nemotron-4 340B商用友好,支援產生合成數據。

資深深度學習研究工程師Somshubra Majumdar對此表示大讚:

你可以用它(免費)產生你想要的所有數據

這一突破性進展,標誌著AI產業的一個重要里程碑——

從此,各行各業都無需依賴大量昂貴的真實世界數據集了,用合成數據,就可以創建性能強大的特定領域LLM!

那麼,英偉達具體是如何實現的呢?

一句話概括,這與它開源通常不發布的獎勵模型有關。

產生高品質合成資料不僅需要優秀的指導模型,還需根據特定需求進行資料篩選。

通常,使用相同模型作為評分者(LLM-as-Judge);但在特定情況下,採用專門的獎勵模型(Reward-Model-as-Judge)進行評估更為合適。

而Nemotron-4 340B指令模型可以產生高品質的數據,然後獎勵模型可以過濾掉多個屬性的數據。

它會根據有用性、正確性、一致性、複雜性和冗長性這5個屬性,對回應評分。

另外,研究者可以使用自己的專用數據,再結合HelpSteer2資料集,客製化Nemotron-4 340B基礎模型,以建立自己的指令或獎勵模型。

回到開頭和Llama-3-70B的對戰,Nemotron-4 340B擁有更寬鬆的許可,或許這才是它的真正價值所在。

畢竟數據短缺早已成為業界普遍痛點。

根據Epoch研究所的AI研究員Pablo Villalobos預測,到2024年年中,對高品質數據的需求超過供給的可能性為50%,到2026年發生這種情況的可能性為90%。

新的預期顯示,這種短缺風險將延遲至2028年。

合成數據才是未來正逐漸成為產業共識…

模型位址:https://huggingface.co/nvidia/Nemotron-4-340B-Instruct