OpenAI工程師必備經典《苦澀的教訓》,原來20多年前就有了原型

OpenAI 推出影片生成模型Sora 已經一週的時間了,熱度不減,作者團隊還在持續放出讓人眼前一亮的影片。例如「一群愛冒險的小狗探索天空廢墟的電影預告片」,Sora 一次生成並自己完成剪輯。

當然,一個個生動、逼真的AI 影片讓人們好奇為什麼是OpenAI 率先打造出了Sora 並能夠跑通所有AGI 技術棧呢?這個問題在社群媒體上引發了熱烈的討論。

其中,在一篇知乎文章中,加州大學柏克萊分校電腦科學博士、作者@SIY.Z 分析了OpenAI 成功的一些方法論,他認為OpenAI 的方法論就是通往AGI 的方法論,而該方法論建構在幾個在重要的「公理」之上,包括了The bitter lesson、Scaling Law 和Emerging properties。

知乎原貼:https://www.zhihu.com/question/644486081/answer/3398751210?utm_psn=1743584603837992961

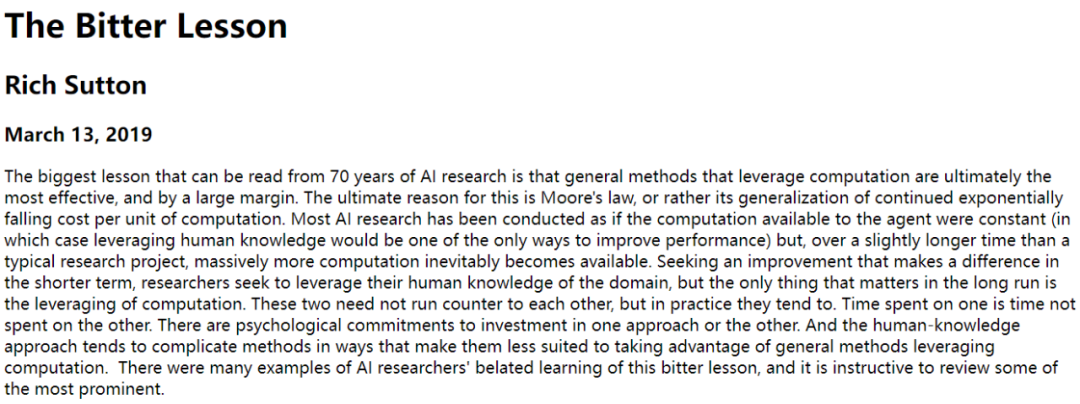

其中The bitter lesson 源自機器學習先驅Rich Sutton 在2019 年的一篇經典文章《苦澀的教訓》, 透過探討人工智慧近幾十年所走過的彎路,他拋出的核心觀點是:人工智慧如果想要長期獲得提升,利用強大的算力才是王道。這裡的算力隱含了大量的訓練資料和大模型。

原文連結:http://www.incompleteideas.net/IncIdeas/BitterLesson.html

因此,作者@SIY.Z 認為某種意義上,強大算力加持的通用AI 演算法才是AGI 路徑的王道和AI 技術真正進步的方向。有了大模型、大算力和大數據,The bitter lesson 構成了AGI 的必要條件。再加上Scaling Law 這項充分條件,透過演算法讓大模型、大算力和大數據獲得更好的結果。

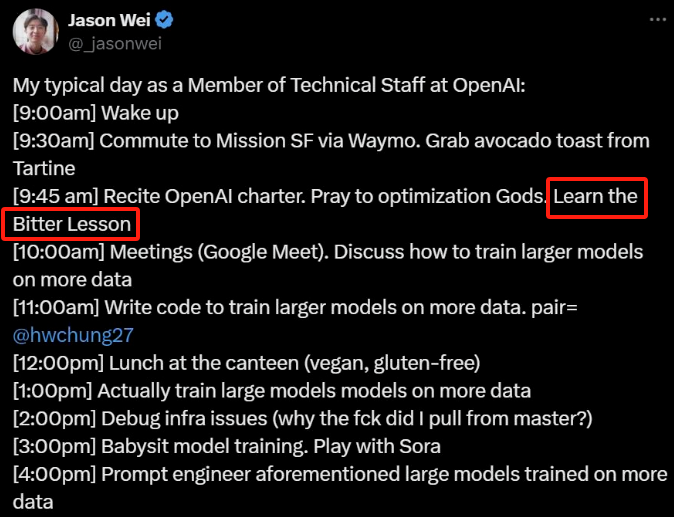

無獨有偶,本週被瘋傳的OpenAI 研究人員 Jason Wei 的每日工作時間線中也提到了Rich Sutton 的The bitter lesson。由此可見,許多業內人士將The bitter lesson 視為圭臬。

來源:https://twitter.com/_jasonwei/status/1760032264120041684

同時,在另一個關於「大語言模型(LLM)是否可以作為自身結果的驗證者」的討論中,有人認為LLM 驗證自身結果時根本不夠準確,並且會導致性能更差(還需要為API付出很多代價)。

來源:https://twitter.com/curious_vii/status/1759930194935029767

對於這個觀點,又有推特網友在Rich Sutton 二十多年前的一篇部落格中有了重要的發現。

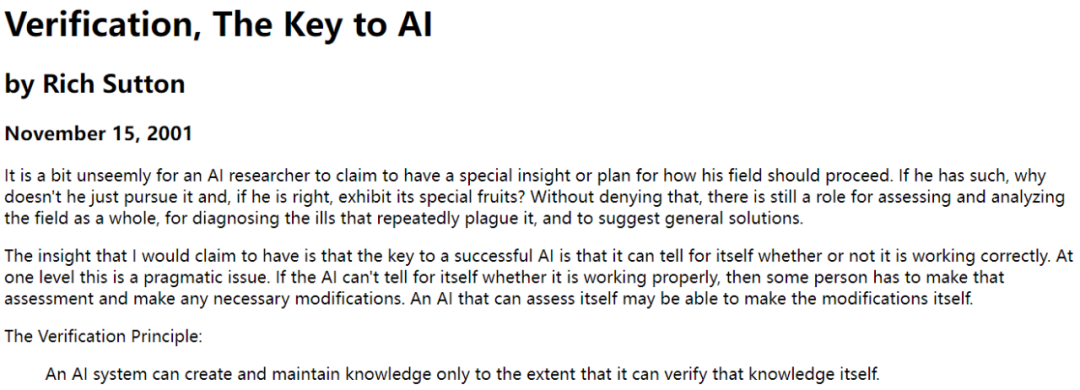

原文連結:http://incompleteideas.net/IncIdeas/KeytoAI.html

部落格中是這樣說的:

考慮到任何AI 系統以及它所擁有的知識,它可能是一個專家系統或像CYC 這樣的大型資料庫。或者它可能是一個熟悉建築物佈局的機器人,或者了解在各種處境下如何做出反應。在所有這些情況下,我們可以問AI 系統是否可以驗證自己的知識,或者是否需要人們幹預來檢測誤差和不可預見的交互,並進行修正。在後者這種情況下,我們永遠無法建立真正龐大的知識系統。它們總是脆弱且不可靠的,而且規模僅限於人們可以監控和了解的範疇。

沒想到,Rich Sutton 進行了回帖,表示這篇寫了一半的部落格是The bitter lesson 的原型。

來源:https://twitter.com/RichardSSutton/status/1760104125625459171

其實,在OpenAI 剛發布Sora 不久,就有很多人意識到了The bitter lesson 發揮了重要作用。

還有人將The bitter lesson 與Transformer 論文Attention is All You Need 並列看待。

資料來源:https://twitter.com/karanganesan/status/1759782109399662777

文章最後,我們回顧Rich Sutton 的《苦澀的教訓》全文。

70 年的人工智慧研究史告訴我們,利用運算能力的一般方法最終是最有效的方法。這個歸摩爾定律解釋,或它對每單位計算成本持續指數級下降的概括。大部分的AI 研究都是在認為智能體可用的計算為恆定的情況下進行(在這種情況下,利用人類知識是提高性能的唯一方法),但是,在比典型研究項目稍長的時間尺度內,我們不可避免地會需要大量的計算。

要在短期內有所提升,研究人員要利用專門領域的人類知識。但如果想要長期的獲得提升,利用運算能力才是王道。這兩者本來無需對立,但實際上它們往往如此。花時間研究一個,就會忽略另一個。利用人類知識的方法容易複雜化,導致其不太適合利用計算的方法。許多例子顯示AI 研究人員對這些教訓的認識太晚,因此我們有必要回顧一些突出的例子。

在電腦國際象棋中,1997 年擊敗世界冠軍卡斯帕羅夫的方法是基於大量深度搜尋。當時,大多數AI 電腦象棋研究人員沮喪地發現了這一點,他們的方法是利用人類對象棋特殊結構的理解。當這個利用硬體和軟體的基於搜尋的更簡單方法被證明更有效時,這些基於人類知識的象棋研究人員卻仍不肯認輸。他們認為雖然這個「暴力」搜尋方法這次贏了,但它並不是一個普遍的策略,無論如何它不是人類下西洋棋的方法。這些研究人員希望基於人類輸入的方法獲勝,但結果卻令他們失望了。

電腦圍棋中也有類似的研究進展模式,只是晚了20 年。最初研究人員努力利用人類知識或遊戲的特殊性來避免搜索,但所有的努力都被證明沒什麼用,因為搜索被大規模地有效應用。同樣重要的是利用自我對弈(self play)來學習一種價值函數(就像在許多其他遊戲甚至國際象棋中一樣,雖然在1997 年首次擊敗世界冠軍的比賽中沒起到什麼作用)。透過自我對弈學習和一般學習有點像搜索,因為它能讓大量的計算發揮作用。搜尋和學習是人工智慧研究中利用大量計算的兩種最重要技術。在電腦圍棋中,就像電腦西洋棋中一樣,研究人員最初是想透過人類理解(這樣無需太多搜尋)來實現目的,只是在後來,透過搜尋和學習才取得了巨大成功。

在語音辨識領域,早在上世紀70 年代就有一場由DARPA 贊助的競賽。參賽者利用了許多利用人類知識的特殊方法:單字、因素和人類聲道等。另一方面,也有人利用了基於隱馬可夫模型的新方法,這些方法在本質上更具統計性,計算量也更大。同樣,統計方法戰勝了基於人類知識的方法。這導致了自然語言處理領域的重大改變,過去幾十年來,統計和計算在該領域逐漸佔據主導地位。深度學習最近在語音辨識中的興起正是朝著這一方向邁出的最新一步。

深度學習方法更少依賴人類知識,使用更多的計算,並且伴隨大量訓練集的學習,從而產生更好的語音識別系統。就像在遊戲中一樣,研究人員總是試圖讓系統按照他們的思維方式進行運作—— 他們試圖將知識放在系統中—— 但事實證明,最終結果往往事與願違,並且極大浪費了研究人員的時間。但是透過摩爾定律,研究人員可以進行大量計算,並找到有效利用的方法。

電腦視覺領域存在相似的模式。早期方法認為視覺是為了搜尋邊緣、廣義圓柱體或取決於SIFT 特徵。但是今天,所有這些方法都被拋棄了。現代深度學習神經網路僅使用卷積和某些不變性的概念即可以取得更好的效果。

這是一個非常大的教訓。因為我們還在犯同一類錯誤,所以依然未能徹底了解人工智慧領域。要看到這一點並且有效地避免重蹈覆轍,我們必須理解這些錯誤為何會讓我們誤入歧途。我們必須吸取慘痛的教訓,從長遠看,固守我們的思考模式是行不通的。痛苦的教訓是基於以下歷史觀察:

- AI 研究人員常常試圖在自身智能體中建構知識,

- 從短期看,這通常是有幫助的,能夠令研究人員滿意,

- 但從長遠看,這會令研究人員停滯不前,甚至抑制進一步發展,

- 突破性進展最終可能會透過相反的方法—— 基於以大規模計算為基礎的搜尋和學習。最後的成功往往帶有一絲苦澀,並且無法完全消化,因為這種成功不是透過一種令人喜歡、以人為中心的方法獲得的。

我們應該從痛苦的教訓中學到的一點:通用方法非常強大,這類方法會隨著算力的增加而繼續擴展,即使可用計算變得非常大。搜尋和學習似乎正是兩種以這種方式隨意擴展的方法。

強化學習教父Richard S. Sutton,現任加拿大阿爾伯塔大學教授。

我們從痛苦的教訓中學到的第二個普遍觀點是,意識的實際內容是極其複雜的;我們不應該試圖透過簡單方法來思考意識的內容,例如思考空間、物體、多智能體或對稱性。所有這些都是任意的、本質上複雜的外在世界的一部分。

它們不應該被固有化,原因是複雜性是無窮無盡的;相反,我們只應該建構可以找到並捕捉這種任意複雜性的元方法。這些方法的關鍵在於它們能夠找到很好的近似值,但對它們的搜尋應該由我們的方法完成,而不是我們自己。

我們希望AI 智能體可以像我們一樣發現新事物,而不是重新找到我們所發現的。在我們發現的基礎上建構只能令人更加難以看清發現過程的完成情況。