K8s-服務網格實戰-入門Istio

K8s-服務網格實戰-入門Istio

背景

終於進入大家都比較有興趣的服務網格系列了,前面已經講解了:

- 如何部署應用程式到 kubernetes

- 服務之間如何調用

- 如何透過網域存取我們的服務

- 如何使用 kubernetes 隨附的設定 ConfigMap

基本上已經夠我們開發一般規模的web 應用了;但在企業中往往有著複雜的應用呼叫關係,應用與應用之間的請求也需要管理。例如常見的限流、降級、trace、監控、負載平衡等功能。

在我們使用 kubernetes 之前往往都是由微服務框架來解決這些問題,例如Dubbo、SpringCloud 都有對應的功能。

但當我們上了 kubernetes 之後這些事情就應該交給一個專門的雲端原生元件來解決,也就是本次會講到的 Istio,它是目前使用最為廣泛的服務網格解決方案。

圖片

圖片

官方對於Istio 的解釋比較簡潔,落到具體的功能點也就是剛才提到的:

- 限流降級

- 路由轉送、負載平衡

- 入口網關、TLS安全認證

- 灰階發布等

圖片

圖片

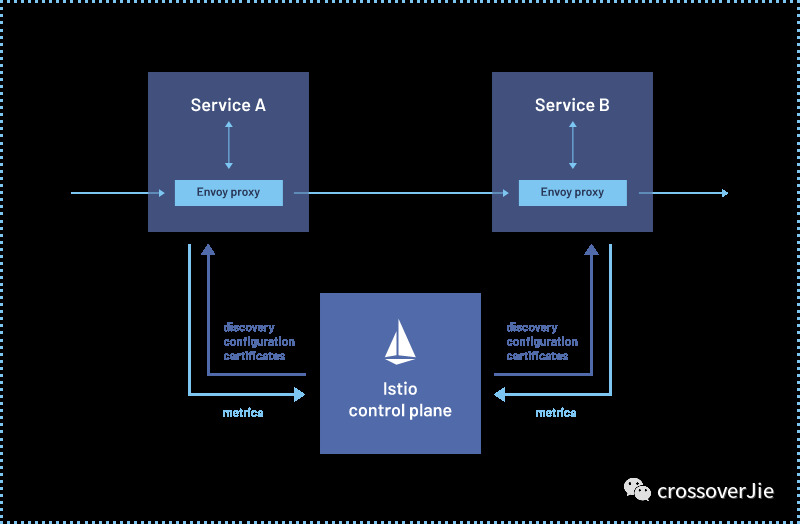

再結合官方的架構圖可知:Istio 分為控制面 control plane 和資料面 data plane。

控制面可以理解為Istio 本身的管理功能:

- 例如服務註冊發現

- 管理配置資料面所需的網路規則等

而數據面可以簡單的把他理解為由 Envoy 代理的我們的業務應用,我們應用中所有的流量進出都會經過 Envoy 代理。

所以它可以實現負載平衡、熔斷保護、認證授權等功能。

安裝

首先安裝Istio 命令列工具

這裡的前提是有一個kubernetes 運行環境

Linux 使用:

curl -L https://istio.io/downloadIstio | sh -- 1.

Mac 可以使用brew:

brew install istioctl- 1.

其他環境可以下載Istio 後配置環境變數:

export PATH=$PWD/bin:$PATH- 1.

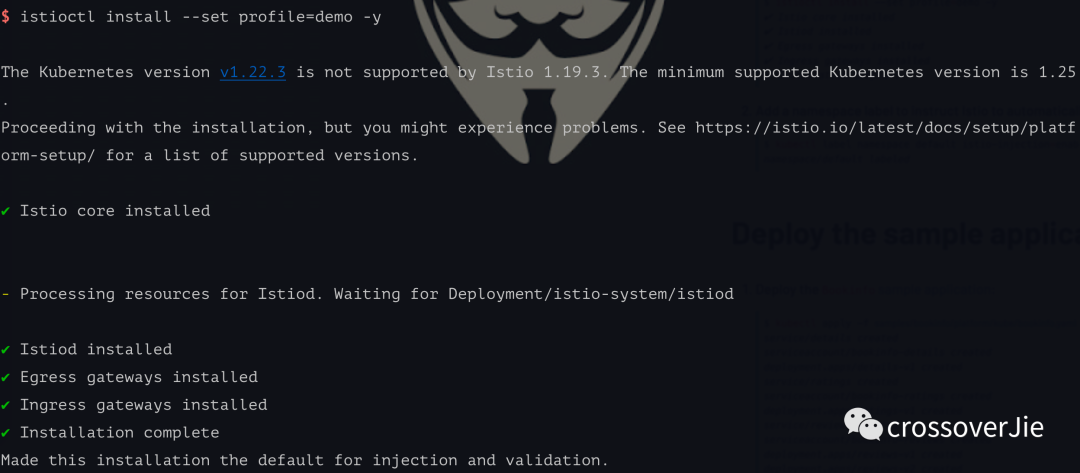

之後我們可以使用 install 指令安裝控制面。

這裡預設使用的是 kubectl 所配置的 kubernetes 集群

istioctl install --set profile=demo -y- 1.

圖片

圖片

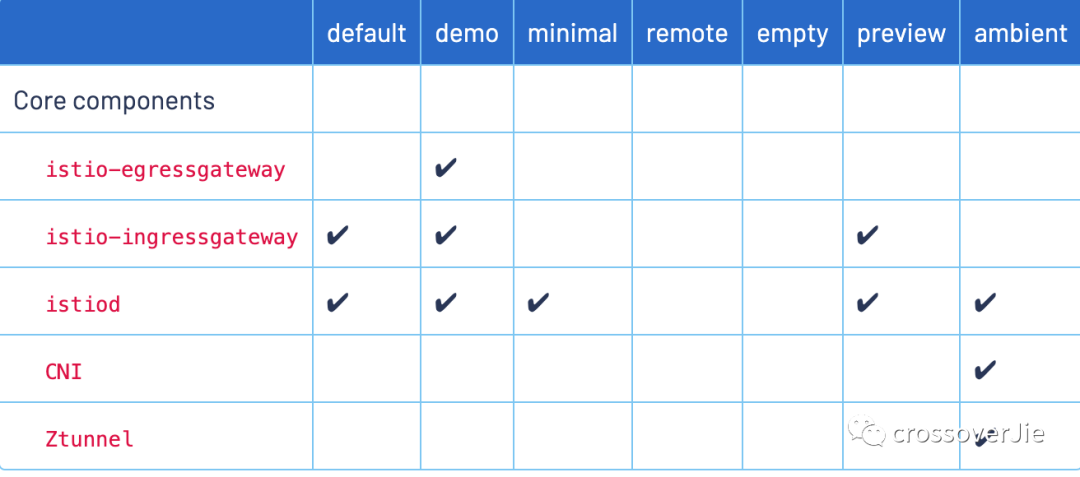

這個的 profile 還有以下不同的值,為了示範我們使用 demo 即可。

圖片

圖片

使用

# 开启 default 命名空间自动注入

$ k label namespace default istio-injectinotallow=enabled

$ k describe ns default

Name: default

Labels: istio-injectinotallow=enabled

kubernetes.io/metadata.name=default

Annotations: <none>

Status: Active

No resource quota.

No LimitRange resource.- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

- 9.

- 10.

- 11.

之後我們為 namespace 打上 label,讓Istio 控制面知道哪個 namespace 下的 Pod 會自動注入 sidecar。

這裡我們為default 這個命名空間開啟自動注入 sidecar,然後在這裡部署我們之前使用到的deployment-istio.yaml

$ k apply -f deployment/deployment-istio.yaml

$ k get pod

NAME READY STATUS RESTARTS

k8s-combat-service-5bfd78856f-8zjjf 2/2 Running 0

k8s-combat-service-5bfd78856f-mblqd 2/2 Running 0

k8s-combat-service-5bfd78856f-wlc8z 2/2 Running 0- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

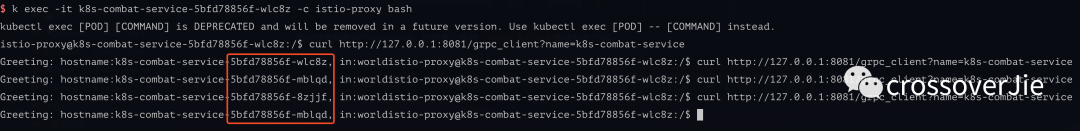

此時會看到每個Pod 有兩個container(其中一個就是istio-proxy sidecar),也就是之前做 gRPC 負載平衡測試時的程式碼。

圖片

圖片

還是進行負載平衡測試,效果是一樣的,說明 Istio 起作用了。

此時我們再觀察 sidecar 的日誌時,會看到剛才我們所發出和接受到的流量:

$ k logs -f k8s-combat-service-5bfd78856f-wlc8z -c istio-proxy

[2023-10-31T14:52:14.279Z] "POST /helloworld.Greeter/SayHello HTTP/2" 200 - via_upstream - "-" 12 61 14 9 "-" "grpc-go/1.58.3" "6d293d32-af96-9f87-a8e4-6665632f7236" "k8s-combat-service:50051" "172.17.0.9:50051" inbound|50051|| 127.0.0.6:42051 172.17.0.9:50051 172.17.0.9:40804 outbound_.50051_._.k8s-combat-service.default.svc.cluster.local default

[2023-10-31T14:52:14.246Z] "POST /helloworld.Greeter/SayHello HTTP/2" 200 - via_upstream - "-" 12 61 58 39 "-" "grpc-go/1.58.3" "6d293d32-af96-9f87-a8e4-6665632f7236" "k8s-combat-service:50051" "172.17.0.9:50051" outbound|50051||k8s-combat-service.default.svc.cluster.local 172.17.0.9:40804 10.101.204.13:50051 172.17.0.9:54012 - default

[2023-10-31T14:52:15.659Z] "POST /helloworld.Greeter/SayHello HTTP/2" 200 - via_upstream - "-" 12 61 35 34 "-" "grpc-go/1.58.3" "ed8ab4f2-384d-98da-81b7-d4466eaf0207" "k8s-combat-service:50051" "172.17.0.10:50051" outbound|50051||k8s-combat-service.default.svc.cluster.local 172.17.0.9:39800 10.101.204.13:50051 172.17.0.9:54012 - default

[2023-10-31T14:52:16.524Z] "POST /helloworld.Greeter/SayHello HTTP/2" 200 - via_upstream - "-" 12 61 28 26 "-" "grpc-go/1.58.3" "67a22028-dfb3-92ca-aa23-573660b30dd4" "k8s-combat-service:50051" "172.17.0.8:50051" outbound|50051||k8s-combat-service.default.svc.cluster.local 172.17.0.9:44580 10.101.204.13:50051 172.17.0.9:54012 - default

[2023-10-31T14:52:16.680Z] "POST /helloworld.Greeter/SayHello HTTP/2" 200 - via_upstream - "-" 12 61 2 2 "-" "grpc-go/1.58.3" "b4761d9f-7e4c-9f2c-b06f-64a028faa5bc" "k8s-combat-service:50051" "172.17.0.10:50051" outbound|50051||k8s-combat-service.default.svc.cluster.local 172.17.0.9:39800 10.101.204.13:50051 172.17.0.9:54012 - default- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

總結

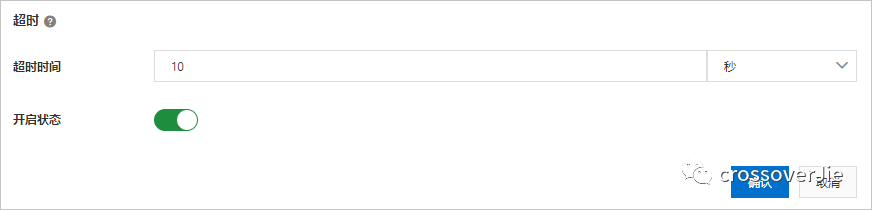

本期的內容較簡單,主要和安裝配置相關,下一期更新如何配置內部服務呼叫的逾時、限流等功能。

其實目前大部分操作都是偏運維的,即便是後續的超時配置等功能都只是編寫yaml 資源。

但在生產使用時,我們會為開發者提供一個管理台的視覺化頁面,可供他們自己靈活配置這些原本需要在 yaml 中配置的功能。

圖片

圖片

其實各大雲平台廠商都有提供類似的能力,例如阿里雲的EDAS 等。

本文的所有原始碼在這裡可以訪問:https://github.com/crossoverJie/k8s-combat