用DDC來構建AI網絡?這可能只是一個美好的幻覺

ChatGPT、AIGC、大模型……一系列眼花繚亂的名詞橫空出世,AI商業價值引發社會的高度關注。隨著訓練模型規模的增長,支撐AI算力的數據中心網絡也成為熱點。提升算力效率,構建高性能網絡……大廠們各顯神通,努力在以太產業宏圖上開闢AI網絡的“F1新賽道”。

在這場AI的軍備競賽中,DDC高調出鏡,一夜之間似乎成為了構建高性能AI網絡革命性技術的代名詞。但真如看上去那麼美好嗎?讓我們詳細分析,冷靜判斷。

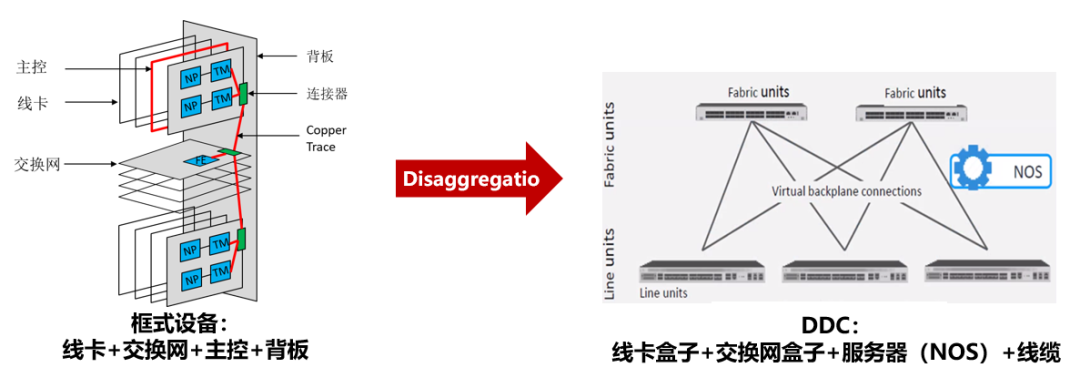

始於2019年,DDC的本質是以盒盒路由器替代框式路由器

隨著DCN流量的快速增長,DCI網絡升級需求日益迫切。然而,DCI路由器框式設備擴容能力受機框大小限制;同時設備功耗大,擴容機框時對機櫃電力、散熱等要求較高,改造成本高。在此背景下,2019年AT&T向OCP提交了基於商用芯片的盒式路由器規範,提出了DDC(Disaggregated Distributed Chassis)的概念。簡單來說,DDC就是使用若干個低功耗盒式設備組成的集群替換框式設備業務線卡和網板等硬件單元,盒式設備間通過線纜互聯。整個集群通過集中式或者分佈式的NOS(網絡操作系統)管理,以期突破DCI單框設備性能和功耗瓶頸的問題。

DDC宣稱的優勢包括:

突破框式設備擴容限制:通過多設備集群實現擴容,不受機框尺寸限制;

降低單點功耗:多台低功耗的盒式設備分散部署,解決了功耗集中的問題,降低機櫃電力和散熱的要求;

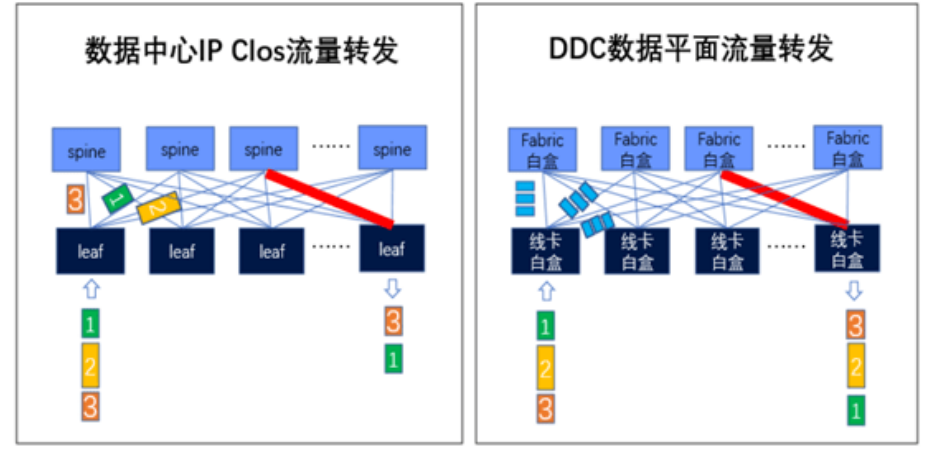

提升帶寬利用率:與傳統的ETH網Hash交換相比,DDC採用信元(Cell)交換,基於Cell進行負載均衡,有助於提升帶寬利用率;

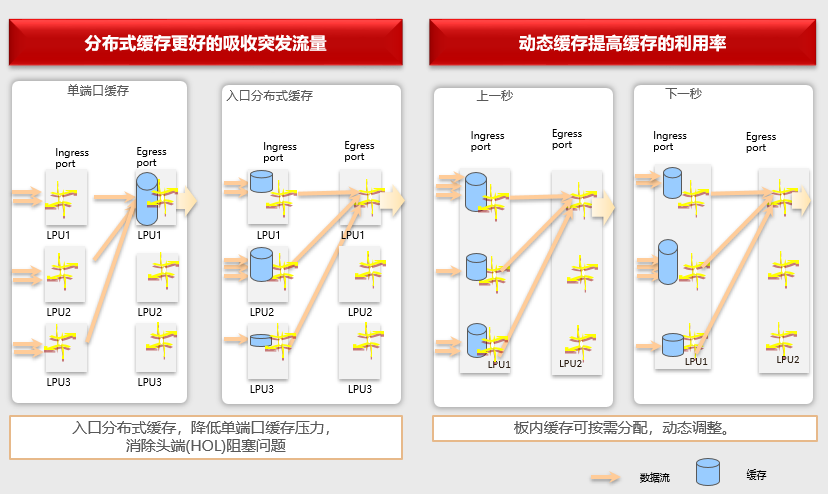

緩解丟包:使用設備大緩存能力滿足DCI場景高收斂比要求。先通過VOQ(Virtual Output Queue)技術先將網絡中接收到的報文分配到不同的虛擬出隊列中,再通過Credit通信機制確定接收端有足夠的緩存空間後再發送這些報文,從而減少由於出口擁塞帶來的丟包。

DDC方案在DCI場景僅曇花一現

想法看起來很完美,可落地卻並非一帆風順。DriveNets公司的Network Cloud產品是業界第一個、也是唯一一個商用的DDC解決方案,整套軟件適配通用白盒路由器。但至今在市面上未見到明確的銷售案例。AT&T作為DDC架構方案提出者,在2020年自建的IP骨幹網中灰度部署了DDC方案,但後續也基本沒有多少聲響。為什麼這朵水花並沒有掀起多大的浪呢?這應該歸咎於DDC存在的四大缺陷。

缺陷一:不可靠的設備管控平面

框式設備各部件通過硬件高度集成、可靠性極高的PCIe總線實現控制管理面互聯,並設備都使用雙主控板設計,確保設備的管控平面高可靠。DDC則使用“壞了就換”的易損模塊線纜互聯,構築多設備集群並支撐集群管控平面運行。雖突破了框式設備的規模,但這種不可靠的互聯方式給管控面帶來了極大風險。兩台設備堆疊,異常時會出現腦裂、表項不同步等問題。對於DDC這不可靠的管控平面而言,這種問題更容易發生。

缺陷二:高度複雜的設備NOS

SONiC社區已有基於VOQ架構下的分佈式轉發機框設計,並持續迭代補充和修改以便於滿足對DDC的支持。雖然白盒確實已經有很多落地案例,但“白框”卻少有人挑戰。構築一個拉遠的“白框”,不僅僅需要考慮集群內多設備的狀態、表項信息的同步和管理,還需要考慮到版本升級、回滾、熱補丁等多個實際場景在多設備下的系統化實現。DDC對集群的NOS複雜度要求指數級提升,目前業界沒有成熟商用案例,存在很大的開發風險。

缺陷三:可維護方案缺失

網絡是不可靠的,因此ETH網絡做了大量可維護和可定位的特性或工具,比如耳熟能詳的INT、MOD。這些工具可以對具體的流進行監控,識別丟包的流特徵,從而進行定位排障。但DDC使用的信元僅是報文的一個切片,沒有相關IP等五元組信息,無法關聯到具體的業務流。DDC一旦出現丟包問題,當前的運維手段無法定位到丟包點,維護方案嚴重缺失。

缺陷四:成本提升

DDC為突破機框尺寸限制,需要將集群的各設備通過高速的線纜/模塊互聯;互聯成本是遠高於框式設備線卡和網板之間通過PCB走線和高速鏈接器互聯,且規模越大互聯成本越高。

同時為降低單點功耗集中,通過線纜/模塊互聯的DDC集群整體功耗高於框式設備。相同一代的芯片,假設DDC集群設備之間用模塊互聯,集群功耗較框式設備高30%。

拒絕炒剩飯,DDC方案同樣不適用於AI網絡

DDC方案的不成熟和不完善,在DCI場景上已黯然退場。但當前在AI風口下竟然死灰復燃。筆者認為,DDC同樣不適用於AI網絡,接下來我們詳細分析。

AI網絡的兩大核心訴求:高吞吐、低時延

AI網絡支撐的業務其特徵是流數量少,單條流的帶寬大;同時流量不均勻,經常出現多打一或者多打多的情況(All-to-All和All-Reduce)。所以極易出現流量負載不均、鏈路利用率低、頻繁的流量擁塞導致的丟包等問題,無法充分釋放算力。

DDC僅解決了Hash問題,同樣帶來眾多缺陷

DDC使用信元交換將報文切片成Cells,並根據可達信息採用輪詢機制發送。流量負載會較為均衡的分配到每一條鏈路,實現帶寬的充分利用,並較好解決了Hash問題。但在這個之外,DDC在AI場景依然存在四大缺陷。

缺陷一:硬件要求特定設備,封閉專網不通用

DDC架構中的信元交換和VOQ技術,均依賴特定硬件芯片實現。當前DCN網絡設備均無法利舊使用。ETH網的飛速發展,得益於其即插即用的便利和通用化、標準化。DCC依賴硬件並通過私有的交換協議構建了一張封閉的專網,並不通用。

缺陷二:大緩存設計增加網絡成本,不適合大規格DCN組網

DDC方案若進入DCN,除去高昂的互聯成本外,還背負著芯片大緩存的成本負擔。DCN網絡當前均使用小緩存設備,最大僅64M;而源於DCI場景的DDC方案通常芯片的HBM達到上GB。大規模的DCN網絡相較DCI而言,更在意網絡成本。

缺陷三:網絡靜態時延增加,不匹配AI場景

作為釋放算力的高性能AI網絡,目標時縮短業務的完成時間。DDC的大緩存能力將報文緩存,勢必增加硬件轉發靜態時延。同時信元交換,對報文的切片、封裝和重組,同樣增加網絡轉發時延。通過測試數據比較,DDC較傳統ETH網轉發時延增大1.4倍。

缺陷四:隨著DC規模增大,DDC不可靠的問題會更加劣化

相對DDC在DCI場景替代框式設備的場景而言,DDC進入DCN需要滿足更大的一個集群,至少要滿足一個網絡POD。這意味著這個拉遠的“框“,各個部件距離更遠。那麼對於這個集群的管控平面的可靠性、設備網絡NOS的同步管理、網絡POD級的運維管理要求更高。DDC的各種缺陷將會裂化。

DDC最多是個過渡方案

當然,任何問題都不是不能解決的。接受部分約束,對於這種特定場景,很容易成為各個大廠“炫技”的舞台。網絡追求可靠、極簡、高效,厭棄複雜度。特別是當前“減員增效”的大背景下,確實要考慮下DDC落地的代價。

在AI場景下面對網絡負載分擔問題,當前已經有很多案例通過轉發路徑的全局靜態或動態編排解決,未來也可以通過端側的網卡基於Packet Spray和亂序重排解決。所以DDC最多是個短期過渡方案。

深度扒一扒,DDC背後的推手或許是DNX

最後說下主流網絡芯片公司博通(Broadcom),我們較為熟悉的有StrataXGS和StrataDNX兩個產品系列。XGS延續高帶寬、低成本的路線,快速推出小緩存、大帶寬的芯片產品,在DCN網絡佔用率持續獨占鰲頭。StrataDNX卻背著大緩存的成本,延續著VOQ+信元交換的神話,期望DDC進入DC續命。北美似乎並無案例,國內DDC或許是DNX最後的救命稻草吧。

當今GPU等大量硬件設施在我國已經受到一定程度的限制,我們真的需要DDC麼?還是多給國產化器件留些機會吧!